Rotular dados pode ser uma tarefa árdua. É a principal fonte de sustento para modelos de visão computacional; sem ela, eles teriam muita dificuldade em identificar objetos, pessoas e outras características importantes da imagem. No entanto, produzir apenas uma hora de dados marcados e rotulados pode levar impressionantes 800 horas de tempo humano. Nossa compreensão de alta fidelidade do mundo se desenvolve à medida que as máquinas podem perceber e interagir melhor com o ambiente. Mas eles precisam de mais ajuda.

Cientistas do Laboratório de Ciência da Computação e Inteligência Artificial (CSAIL) do MIT, da Microsoft e da Cornell University tentaram resolver esse problema que afeta os modelos de visão criando o “STEGO”, um algoritmo que pode descobrir e segmentar conjuntamente objetos sem nenhum rótulo humano em tudo, até o pixel.

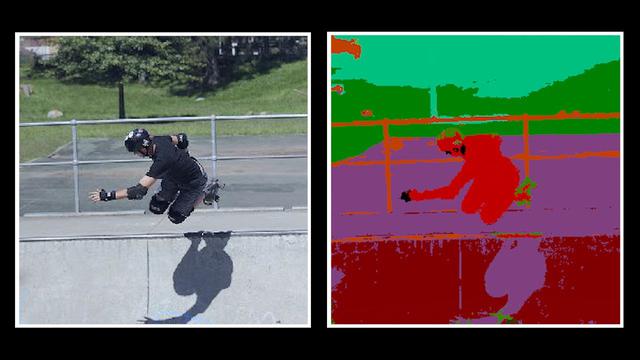

O STEGO aprende algo chamado “segmentação semântica” — linguagem sofisticada para o processo de atribuir um rótulo a cada pixel em uma imagem. A segmentação semântica é uma habilidade importante para os sistemas de visão computacional de hoje porque as imagens podem estar repletas de objetos. Ainda mais desafiador é que esses objetos nem sempre se encaixam em caixas literais; os algoritmos tendem a funcionar melhor para “coisas” discretas, como pessoas e carros, em oposição a “coisas” como vegetação, céu e purê de batatas. Um sistema anterior pode simplesmente perceber uma cena diferenciada de um cachorro brincando no parque como apenas um cachorro, mas ao atribuir um rótulo a cada pixel da imagem, o STEGO pode dividir a imagem em seus ingredientes principais: um cachorro, céu, grama e o seu dono.