Il y a 20 ans cette année, j'ai écrit un livre intitulé "Search Engine Marketing : The Essential Best Practice Guide". Il est généralement considéré comme le premier guide complet sur le référencement et la science sous-jacente de la recherche d'informations (IR).

J'ai pensé qu'il serait utile de regarder ce que j'ai écrit en 2002 pour voir comment cela se compare aujourd'hui. Nous allons commencer par les aspects fondamentaux de ce qu'implique l'exploration du Web.

Il est important de comprendre l'histoire et le contexte d'Internet et d'effectuer des recherches pour comprendre où nous en sommes aujourd'hui et quelle est la prochaine étape. Et laissez-moi vous dire qu'il y a beaucoup de chemin à parcourir.

Notre industrie se précipite maintenant vers une autre nouvelle itération d'Internet. Nous commencerons par passer en revue le travail de base que j'ai couvert en 2002. Ensuite, nous explorerons le présent, avec un regard tourné vers l'avenir du SEO, en examinant quelques exemples importants (par exemple, les données structurées, le cloud computing, l'IoT, l'edge computing, 5G),

Tout cela est un bond en avant par rapport au point de départ d'Internet.

Rejoignez-moi, n'est-ce pas, alors que nous nous promenons dans la mémoire de l'optimisation des moteurs de recherche.

Une leçon d'histoire importante

Nous utilisons les termes World Wide Web et Internet de manière interchangeable. Cependant, ce n'est pas la même chose.

Vous seriez surpris du nombre de personnes qui ne comprennent pas la différence.

La première itération d'Internet a été inventée en 1966. Une autre itération qui l'a rapproché de ce que nous savons maintenant a été inventée en 1973 par le scientifique Vint Cerf (actuellement évangéliste en chef d'Internet pour Google).

Le World Wide Web a été inventé par le scientifique britannique Tim Berners-Lee (aujourd'hui Sir) à la fin des années 1980.

Il est intéressant de noter que la plupart des gens ont l'idée qu'il a passé quelque chose d'équivalent à une vie de recherche scientifique et d'expérimentation avant que son invention ne soit lancée. Mais ce n'est pas du tout le cas. Berners-Lee a inventé le World Wide Web pendant son heure de déjeuner un jour de 1989 alors qu'il dégustait un sandwich au jambon dans le café du personnel du Laboratoire du CERN en Suisse.

Et pour ajouter un peu de clarté au titre de cet article, depuis l'année suivante (1990) le web a été crawlé d'une manière ou d'une autre par un bot ou un autre jusqu'à aujourd'hui (d'où 32 ans de crawling sur le web) .

Pourquoi vous devez savoir tout cela

Le Web n'a jamais été conçu pour faire ce que nous en attendons maintenant (et ces attentes ne cessent de croître).

Berners-Lee a initialement conçu et développé le Web pour répondre à la demande de partage automatisé d'informations entre les scientifiques des universités et des instituts du monde entier.

Ainsi, une grande partie de ce que nous essayons de faire faire au Web est étrangère à l'inventeur et au navigateur (que Berners-Lee a également inventé).

Et cela est très pertinent pour les principaux défis de l'évolutivité auxquels les moteurs de recherche sont confrontés en essayant de récolter du contenu à indexer et à garder à jour, tout en essayant de découvrir et d'indexer de nouveaux contenus.

Les moteurs de recherche ne peuvent pas accéder à l'intégralité du Web

De toute évidence, le World Wide Web s'est accompagné de défis inhérents. Et cela m'amène à un autre fait extrêmement important à souligner.

C'est le "mythe omniprésent" qui a commencé lorsque Google a été lancé pour la première fois et qui semble être aussi omniprésent aujourd'hui qu'il l'était à l'époque. Et c'est la conviction que les gens ont que Google a accès à l'ensemble du Web.

Non. Pas vrai. En fait, loin de là.

Lorsque Google a commencé à explorer le Web en 1998, son index était d'environ 25 millions d'URL uniques. Dix ans plus tard, en 2008, ils ont annoncé qu'ils avaient franchi le cap majeur d'avoir vu 1 000 milliards d'URL uniques sur le Web.

Plus récemment, j'ai vu des chiffres suggérant que Google connaissait quelque 50 000 milliards d'URL. Mais voici la grande différence que nous, SEO, devons tous connaître :

Et 50 000 milliards, c'est beaucoup d'URL. Mais ce n'est qu'une infime partie de l'ensemble du Web.

Google (ou tout autre moteur de recherche) peut explorer une énorme quantité de contenu à la surface du Web. Mais il existe également une énorme quantité de contenu sur le "web profond" auquel les crawlers ne peuvent tout simplement pas accéder. Il est verrouillé derrière des interfaces conduisant à des quantités colossales de contenu de base de données. Comme je l'ai souligné en 2002, les crawlers ne sont pas équipés d'un écran et d'un clavier !

En outre, le chiffre de 50 000 milliards d'URL uniques est arbitraire. Je n'ai aucune idée du chiffre réel de Google en ce moment (et eux-mêmes n'ont aucune idée du nombre de pages qu'il y a réellement sur le World Wide Web non plus).

Ces URL ne mènent pas toutes non plus à un contenu unique. Le Web regorge de spam, de contenu en double, de liens itératifs vers nulle part et de toutes sortes d'autres types de débris Web.

Comprendre l'architecture des moteurs de recherche

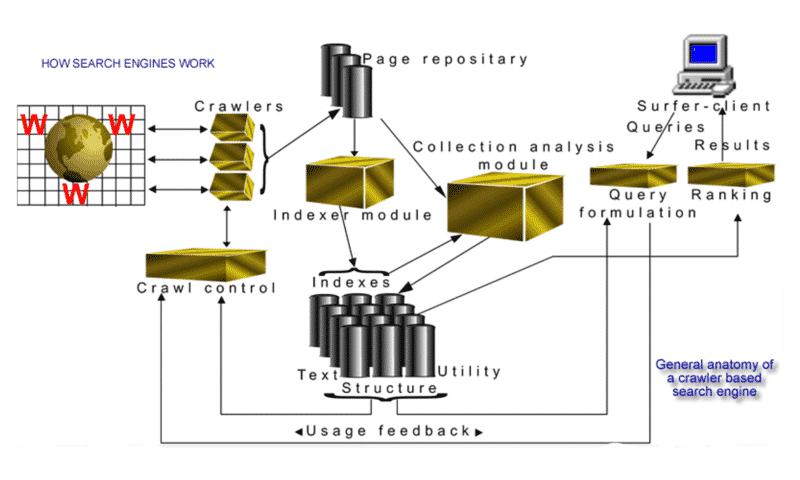

En 2002, j'ai créé une interprétation visuelle de "l'anatomie générale d'un moteur de recherche basé sur un robot" :

De toute évidence, cette image ne m'a valu aucun prix de conception graphique. Mais c'était une indication précise de la façon dont les différents composants d'un moteur de recherche Web se sont réunis en 2002. Cela a certainement aidé l'industrie émergente du référencement à mieux comprendre pourquoi l'industrie et ses pratiques étaient si nécessaires.

Bien que les technologies utilisées par les moteurs de recherche aient considérablement progressé (pensez : intelligence artificielle/apprentissage automatique), les principaux moteurs, processus et données scientifiques sous-jacentes restent les mêmes.

Bien que les termes "apprentissage automatique" et "intelligence artificielle" aient trouvé leur place plus fréquemment dans le lexique de l'industrie ces dernières années, j'ai écrit ceci dans la section sur l'anatomie d'un moteur de recherche il y a 20 ans :

"Dans la conclusion de cette section, j'aborderai les "machines d'apprentissage" (machines à support vectoriel) et l'intelligence artificielle (IA) qui est le domaine de la recherche et de la récupération sur le Web qui doit inévitablement aller ensuite."

Crawlers de moteurs de recherche "nouvelle génération"

Il est difficile de croire qu'il n'y a littéralement qu'une poignée de moteurs de recherche à usage général sur la planète qui explorent le Web, Google étant (sans doute) le plus important. Je dis cela parce qu'en 2002, il y avait des dizaines de moteurs de recherche, avec de nouvelles startups presque chaque semaine.

Comme je côtoie fréquemment des praticiens beaucoup plus jeunes du secteur, je trouve toujours amusant que beaucoup ne réalisent même pas que le référencement existait avant que Google n'existe.

Bien que Google soit largement reconnu pour son approche innovante de la recherche sur le Web, il a beaucoup appris d'un homme du nom de Brian Pinkerton. J'ai eu la chance d'interviewer Pinkerton (à plus d'une occasion).

Il est l'inventeur du premier moteur de recherche de récupération de texte intégral au monde appelé WebCrawler. Et même s'il était en avance sur son temps à l'aube de l'industrie de la recherche, il a bien ri avec moi lorsqu'il m'a expliqué sa première configuration pour un moteur de recherche Web. Il fonctionnait sur une seule machine 486 avec 800 Mo de disque et 128 Mo de mémoire et un seul crawler téléchargeant et stockant les pages de seulement 6 000 sites Web !

Un peu différent de ce que j'écrivais sur Google en 2002 en tant que moteur de recherche de "nouvelle génération" explorant le Web.

"Le mot "crawler" est presque toujours utilisé au singulier ; cependant, la plupart des moteurs de recherche ont en fait un certain nombre de crawlers avec une « flotte » d'agents effectuant le travail à grande échelle. Par exemple, Google, en tant que moteur de recherche de nouvelle génération, a commencé avec quatre crawlers, chacun gardant environ trois cents connexions ouvertes. À des vitesses de pointe, ils téléchargeaient les informations de plus de cent pages par seconde. Google (au moment de la rédaction) s'appuie désormais sur 3 000 PC exécutant Linux, avec plus de quatre-vingt-dix téraoctets de stockage sur disque. Ils ajoutent trente nouvelles machines par jour à leur ferme de serveurs juste pour suivre la croissance.

Et ce modèle de mise à l'échelle et de croissance chez Google s'est poursuivi à un rythme soutenu depuis que j'ai écrit cela. Cela fait un moment que je n'ai pas vu de chiffre précis, mais il y a peut-être quelques années, j'ai vu une estimation selon laquelle Google explorait 20 milliards de pages par jour. C'est probablement encore plus que ça maintenant.

L'analyse des liens hypertexte et l'énigme de l'exploration/l'indexation/de l'ensemble du Web

Est-il possible de se classer dans le top 10 de Google si votre page n'a jamais été explorée ?

Aussi improbable que cela puisse paraître dans la question, la réponse est "oui". Et encore une fois, c'est quelque chose que j'ai abordé en 2002 dans le livre :

De temps en temps, Google renverra une liste, ou même un seul lien vers un document, qui n'a pas encore été exploré, mais avec une notification que le document n'apparaît que parce que les mots-clés apparaissent dans d'autres documents avec des liens, qui pointent vers il.

De quoi s'agit-il ? Comment est-ce possible?

Analyse des liens hypertexte. Oui, ce sont des backlinks !

Il existe une différence entre l'exploration, l'indexation et la simple connaissance des URL uniques. Voici l'explication supplémentaire que j'ai donnée:

"Si vous revenez aux énormes défis décrits dans la section sur l'exploration du Web, il est évident qu'il ne faut jamais supposer, à la suite d'une visite d'un moteur de recherche, que TOUTES les pages de votre site Web ont été indexées. . J'ai des clients avec des sites Web à des degrés divers en nombre de pages. Une cinquantaine, quelque 5 000 et en toute honnêteté, je peux dire qu'aucun d'entre eux n'a chaque page indexée par tous les principaux moteurs de recherche. Tous les principaux moteurs de recherche ont des URL sur la "frontière" du crawl comme on le sait, c'est-à-dire que le contrôle des robots aura fréquemment des millions d'URL dans la base de données, dont il sait qu'elles existent mais qui n'ont pas encore été explorées et téléchargées.

J'ai vu de nombreuses fois des exemples de cela. Les 10 premiers résultats suite à une requête affichaient parfois une URL de base sans titre ni extrait (ou métadonnées).

Voici un exemple que j'ai utilisé dans une présentation de 2004. Regardez le résultat en bas, et vous verrez ce que je veux dire.

Google est conscient de l'importance de cette page en raison des données de liaison qui l'entourent. Mais aucune information complémentaire n'a été extraite de la page, pas même la balise de titre, car la page n'a manifestement pas t été exploré. (Bien sûr, cela peut également se produire avec la petite gaffe qui se produit toujours tout le temps lorsque quelqu'un quitte le fichier robots.txt empêchant le site d'être exploré.)

J'ai surligné cette phrase ci-dessus en gras pour deux raisons importantes :

Je vais juste embellir un peu plus la "politesse" car elle est directement liée au fichier/protocole robots.txt. Tous les défis liés à l'exploration du Web que j'ai expliqués il y a 20 ans existent toujours aujourd'hui (à plus grande échelle).

Étant donné que les robots d'exploration récupèrent les données à une vitesse et à une profondeur bien supérieures à celles des humains, ils peuvent avoir (et ont parfois) un impact paralysant sur les performances d'un site Web. Les serveurs peuvent tomber en panne simplement en essayant de suivre le nombre de requêtes rapides.

C'est pourquoi une politique de politesse régie d'une part par la programmation du crawler et le plot du crawl, et d'autre part par le fichier robots.txt est nécessaire.

Plus un moteur de recherche peut explorer rapidement le nouveau contenu à indexer et réexplorer les pages existantes dans l'index, plus le contenu sera frais.

Vous trouvez le bon équilibre ? C'est la partie la plus difficile.

Disons, purement hypothétiquement, que Google voulait garder une couverture complète des nouvelles et des affaires courantes et a décidé d'essayer d'explorer l'intégralité du site Web du New York Times tous les jours (même toutes les semaines) sans aucun facteur de politesse. Il est fort probable que le robot utilise toute sa bande passante. Et cela signifierait que personne ne peut lire le journal en ligne à cause de l'encombrement de la bande passante.

Heureusement maintenant, au-delà du simple facteur de politesse, nous avons Google Search Console, où il est possible de manipuler la vitesse et la fréquence à laquelle les sites Web sont explorés.

Qu'est-ce qui a changé en 32 ans d'exploration du Web ?

OK, nous avons parcouru beaucoup de chemin, comme je le savais.

Il y a certainement eu de nombreux changements à la fois sur Internet et sur le World Wide Web, mais la partie exploration semble toujours être entravée par les mêmes vieux problèmes.

Cela dit, il y a quelque temps, j'ai vu une présentation d'Andrey Kolobov, chercheur dans le domaine de l'apprentissage automatique chez Bing. Il a créé un algorithme pour faire un acte d'équilibre avec le problème de la bande passante, de la politesse et de l'importance lors du tracé du crawl.

Je l'ai trouvé très instructif, étonnamment simple et assez facile à expliquer. Même si vous ne comprenez pas les calculs, pas de soucis, vous aurez toujours une indication de la façon dont il aborde le problème. Et vous entendrez également à nouveau le mot "importance" dans le mix.

Fondamentalement, comme je l'ai expliqué plus tôt à propos des URL à la frontière de l'exploration, l'analyse des liens hypertexte est importante avant d'être exploré, et pourrait bien être la raison de la rapidité avec laquelle vous êtes exploré. Vous pouvez visionner la courte vidéo de sa présentation ici.

Terminons maintenant avec ce qui se passe avec Internet en ce moment et comment le Web, Internet, la 5G et les formats de contenu améliorés se développent.

Données structurées

Le Web a été une mer de données non structurées dès le départ. C'est ainsi qu'il a été inventé. Et comme il continue de croître de façon exponentielle chaque jour, le défi des moteurs de recherche est de devoir explorer et réexplorer les documents existants dans l'index pour analyser et mettre à jour si des modifications ont été apportées pour maintenir l'index à jour.

C'est une tâche colossale.

Ce serait tellement plus facile si les données étaient structurées. Et c'est en grande partie le cas, car les bases de données structurées pilotent de nombreux sites Web. Mais le contenu et la présentation sont séparés, bien sûr, car le contenu doit être publié uniquement en HTML.

Il y a eu de nombreuses tentatives dont j'ai eu connaissance au fil des ans, où des extracteurs personnalisés ont été créés pour tenter de convertir le HTML en données structurées. Mais surtout, ces tentatives étaient des opérations très fragiles, assez laborieuses et totalement sujettes à erreur.

Une autre chose qui a complètement changé le jeu est que les sites Web des premiers jours étaient codés à la main et conçus pour les vieilles machines de bureau maladroites. Mais maintenant, le nombre de facteurs de forme différents utilisés pour récupérer les pages Web a considérablement modifié les formats de présentation que les sites Web doivent cibler.

Comme je l'ai dit, en raison des défis inhérents au Web, les moteurs de recherche tels que Google ne seront probablement jamais en mesure d'explorer et d'indexer l'intégralité du Web.

Alors, quelle serait une autre façon d'améliorer considérablement le processus ? Et si nous laissions le crawler continuer à faire son travail habituel et rendions disponible simultanément un flux de données structurées ?

Au cours de la dernière décennie, l'importance et l'utilité de cette idée n'ont cessé de croître. Pour beaucoup, c'est encore une idée assez nouvelle. Mais, encore une fois, Pinkerton, l'inventeur de WebCrawler, était très en avance sur ce sujet il y a 20 ans.

Lui et moi avons discuté de l'idée de flux XML spécifiques à un domaine pour normaliser la syntaxe. À cette époque, XML était nouveau et considéré comme l'avenir du HTML basé sur un navigateur.

C'est ce qu'on appelle extensible parce que ce n'est pas un format fixe comme HTML. XML est un « métalangage » (un langage de description d'autres langages qui vous permet de concevoir vos propres langages de balisage personnalisés pour des types de documents illimités et variés). Diverses autres approches ont été vantées comme l'avenir du HTML mais ne pouvaient pas répondre à l'interopérabilité requise.

Cependant, une approche qui a suscité beaucoup d'attention est connue sous le nom de MCF (Meta Content Framework), qui a introduit des idées du domaine de la représentation des connaissances (cadres et réseaux sémantiques). L'idée était de créer un modèle de données commun sous la forme d'un graphe orienté étiqueté.

Oui, l'idée est devenue plus connue sous le nom de Web sémantique. Et ce que je viens de décrire est la première vision du graphe de connaissances. Cette idée date de 1997, soit dit en passant.

Cela dit, c'est en 2011 que tout a commencé à se mettre en place, avec la création de schema.org par Bing, Google, Yahoo et Yandex. L'idée était de présenter aux webmasters un vocabulaire unique. Différents moteurs de recherche pourraient utiliser le balisage différemment, mais les webmasters n'avaient à faire le travail qu'une seule fois et en récolteraient les bénéfices auprès de plusieurs consommateurs du balisage.

OK – Je ne veux pas m'aventurer trop loin dans l'énorme importance des données structurées pour l'avenir du référencement. Cela doit être un article à part entière. Donc, j'y reviendrai une autre fois en détail.

Mais vous pouvez probablement voir que si Google et d'autres moteurs de recherche ne peuvent pas explorer l'intégralité du Web, l'importance de fournir des données structurées pour les aider à mettre à jour rapidement les pages sans avoir à les réexplorer à plusieurs reprises fait une énorme différence.

Cela dit, et c'est particulièrement important, vous devez toujours faire reconnaître vos données non structurées pour leurs facteurs E-A-T (expertise, autorité, fiabilité) avant que les données structurées n'entrent vraiment en jeu.

Cloud computing

Comme je l'ai déjà évoqué, au cours des quatre dernières décennies, Internet est passé d'un réseau peer-to-peer à la superposition du World Wide Web en une révolution de l'Internet mobile, Cloud computing, Internet des objets, Edge Computing et 5G.

La transition vers le cloud computing nous a donné l'expression "la cloudification d'Internet".

D'énormes centres de données de la taille d'un entrepôt fournissent des services pour gérer l'informatique, le stockage, la mise en réseau, la gestion et le contrôle des données. Cela signifie souvent que les centres de données Cloud sont situés à proximité de centrales hydroélectriques, par exemple, pour fournir l'énorme quantité d'énergie dont ils ont besoin.

Edge computing

Désormais, la "Edgeifacation d'Internet" inverse tout, passant d'être plus éloigné de la source d'utilisateurs à juste à côté.

L'informatique de périphérie concerne les périphériques matériels physiques situés dans des emplacements distants à la périphérie du réseau avec suffisamment de mémoire, de puissance de traitement et de ressources informatiques pour collecter des données, traiter ces données et les exécuter presque en temps réel avec une aide limitée de autres parties du réseau.

En rapprochant les services informatiques de ces emplacements, les utilisateurs bénéficient de services plus rapides et plus fiables avec de meilleures expériences utilisateur et les entreprises bénéficient d'une meilleure capacité à prendre en charge les applications sensibles à la latence, à identifier les tendances et à proposer des produits et services largement supérieurs. Les appareils IoT et les appareils Edge sont souvent utilisés de manière interchangeable.

5G

Avec la 5G et la puissance de l'IoT et de l'informatique en périphérie, la façon dont le contenu est créé et distribué va également changer radicalement.

Nous voyons déjà des éléments de réalité virtuelle (VR) et de réalité augmentée (AR) dans toutes sortes d'applications différentes. Et dans la recherche, ce ne sera pas différent.

L'imagerie en réalité augmentée est une initiative naturelle de Google, et ils s'amusent avec les images 3D depuis quelques années maintenant, en testant, testant, testant comme ils le font. Mais déjà, ils intègrent cet accès à faible latence au graphe de connaissances et apportent du contenu de manière visuellement plus convaincante.

Au plus fort de la pandémie, l'utilisateur final désormais "accéléré numériquement" s'est habitué à interagir avec les images 3D que Google saupoudrait dans le mélange de résultats. Au début c'était des animaux (chiens, ours, requins) puis des voitures.

L'année dernière, Google a annoncé qu'au cours de cette période, les résultats en 3D avaient interagi plus de 200 millions de fois. Cela signifie que la barre a été fixée et que nous devons tous commencer à penser à créer ces expériences de contenu plus riches, car l'utilisateur final (peut-être votre prochain client) attend déjà ce type de contenu amélioré.

Si vous ne l'avez pas encore expérimenté vous-même (et pas tout le monde, même dans notre industrie), voici un régal très cool. Dans cette vidéo de l'année dernière, Google introduit des athlètes célèbres dans le mix AR. Et l'athlète superstar Simone Biles peut interagir avec elle-même AR dans les résultats de recherche.

IoT

Après avoir établi les différentes phases/développements d'Internet, il n'est pas difficile de dire que tout ce qui est connecté d'une manière ou d'une autre sera la force motrice de l'avenir.

En raison du battage médiatique avancé que suscitent de nombreuses technologies, il est facile de les rejeter avec des pensées telles que l'IdO concerne uniquement les ampoules intelligentes et les appareils portables ne concernent que les trackers de fitness et les montres. Mais le monde qui vous entoure est progressivement remodelé d'une manière que vous pouvez à peine imaginer. Ce n'est pas de la science-fiction.

L'IdO et les appareils portables sont deux des technologies à la croissance la plus rapide et des sujets de recherche les plus en vogue qui vont considérablement étendre les applications électroniques grand public (communications en particulier).

Le futur n'est pas en retard cette fois. C'est déjà ici.

Nous vivons dans un monde connecté où des milliards d'ordinateurs, de tablettes, de smartphones, d'appareils portables, de consoles de jeu et même d'appareils médicaux, voire des bâtiments entiers, traitent et transmettent numériquement des informations.

Voici un petit fait intéressant pour vous : on estime que le nombre d'appareils et d'objets connectés à l'IoT dépasse déjà le nombre de personnes sur terre.

Retour vers l'avenir du SEO

Nous nous arrêterons ici. Mais beaucoup plus à venir.

Je prévois de décomposer ce que nous appelons maintenant l'optimisation des moteurs de recherche dans une série d'articles mensuels portant sur les aspects fondamentaux. Cependant, le terme "SEO" n'entrera pas dans le lexique pendant un certain temps, car l'industrie artisanale consistant à "faire des choses pour être trouvé sur les portails des moteurs de recherche" a commencé à émerger du milieu à la fin des années 1990.

D'ici là, portez-vous bien, soyez productif et absorbez tout ce qui vous entoure en ces temps technologiques passionnants. Je reviendrai avec plus dans quelques semaines.

Les opinions exprimées dans cet article sont celles de l'auteur invité et pas nécessairement de Search Engine Land. Les auteurs du personnel sont répertoriés ici.