La nouvelle semaine, le nouveau départ, les grands plans, ne peuvent pas être aussi mauvais que la semaine dernière, mais d'abord, connectez-vous et découvrons ce qui se passe dans le monde.Vidéo Facebook de l'ami, l'homme blessant un chien dans un ascenseur.Commentaire, comme partager;Aimez les animaux, haine la cruauté.Certains idiots répondent: "Nous sommes dans une pandémie, les animaux n'ont pas d'importance".Mettez-le à sa place.Un peu de rangée quand l'autre moitié met notre chat à l'extérieur.Obtenez des friandises plus tard.

Besoin de se détendre maintenant, écoutez quelques morceaux vidéo, puis commencez.L'annonce s'allume - Boire des probiotiques, c'est comme être dans une pagode japonaise ancienne et mystique.Faites défiler le fil d'actualités: le café à emporter «classé comme» pique-niquement par la police coiffée;Le vaccin Pfizer vous transforme en chimpanzé;Big Mad Baby Trump voulait la guerre nucléaire;Pig Pig dans le choc fiscal Brexit..

Vous porte, juste en regardant tout.Et, inexplicablement, vous donne faim tout d'un coup.Heureusement, il est encore temps de se rendre chez McDonald's avant de cesser de servir le petit déjeuner.Au revoir soupe aux légumes faits maison.Un jour de plus devant la télévision ne fera pas de mal.La nouvelle vie peut commencer demain.

Souvent, il semble que, même si nous rêvons pour quelque chose de mieux, la vraie vie se lancera bientôt et nous traînera la tête sans cérémonie des nuages.Sauf, le plus souvent, ce n'est pas la vie qui nous fait cela, ce sont de fausses nouvelles.Ou, pour être précis, les processus qui nous fournissent de fausses nouvelles, la façon dont nous interagissons avec les nouvelles et l'effet que tout cela a sur nous.

Nous avons tous entendu les histoires inventées sur les politiciens, les célébrités, la 5G et le Covid-19, mais ce n'est qu'un élément de la fausse bombardement des nouvelles, à laquelle nous sommes de plus en plus soumis à chaque fois que nous allons en ligne.

Même le terme «fausses nouvelles» est faux, comme en se concentrant sur le contenu (je.e.les «nouvelles») il se cache à la vue, le faux inhérent au processus de communication du Faker.La discussion ultérieure est alors axée uniquement sur un élément de contenu, avec lequel nous, ou la société, sommes d'accord ou en désaccord.

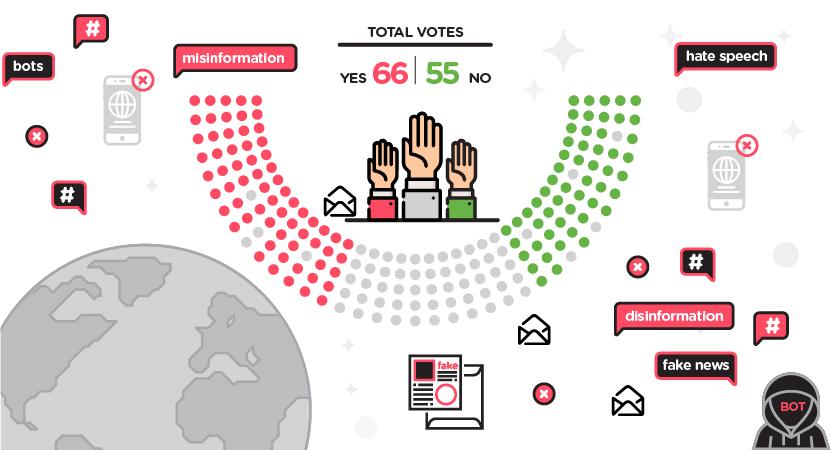

La désinformation manipulative décrirait plus précisément ce à quoi nous sommes exposés, en ligne, quotidiennement.Le rapport d'une commission de l'UE sur les fausses nouvelles et la désinformation en ligne, en mars dernier, a fait référence à la nécessité de faire face à «toutes les formes d'informations fausses, inexactes ou trompeuses conçues, présentées et promues pour causer intentionnellement les préjudices du public ou le profit».

Les assaillants ont beaucoup de trucs subtils pour faire passer leurs messages au-delà de notre radar et dans nos esprits.Comme le montre le scénario d'introduction, ils pourraient essayer de cacher la source de leur contenu et de présenter un ancien contenu comme actuel.L'imagerie déclenche des associations positives, la tenue passive cache leur propre motivation, leur perspective et le processus de cause à effet.Ils feront des commentaires biaisés et exagéreront les affirmations tout en prêchant l'objectivité.Ils présenteront l'opinion comme des faits et sélectionneront et omettront délibérément le contenu, pour effet.

Les assaillants pourraient être des anti-Vaxxers, des médecins de spin politiques, des consultants en marketing ou simplement des fantasmes trompés avec un ordinateur portable;Mais ils veulent tous la même chose, que leur intervention dans nos vies devrait évoquer une réponse souhaitée.Mélanger les émotions, déclencher des envies pour manger, fumer, boire, utiliser, acheter, voter, rejoindre, publier.

En utilisant ces tromperies, les Fakers peuvent orienter, influencer et favoriser la dépendance.Et comme des lemmings à une falaise, nous les suivons, ignorant parfaitement ce qui se passe.

Edward Bernays (1891-1995) n'est pas un nom familier, ce qui est approprié compte tenu de la nature de son immense, mais presque cachée, une influence sur le monde moderne.

Bernays était le neveu de Freud et au début des décennies du XXe siècle, il a appliqué les idées de son oncle sur la psyché humaine au monde de la publicité, du marketing, de la propagande et de l'ingénierie sociale.Bernays a écrit des livres à succès, a travaillé pour les gouvernements et les entreprises et a légué au monde de nombreux arts sombres utilisés par les manipulateurs en ligne d'aujourd'hui.

Bernays croyait que les masses étaient motivées par des facteurs en dehors de leur compréhension, ce qui les a laissés ouverts à la manipulation par quelques-uns capables."Si nous comprenons le mécanisme et les motifs de l'esprit du groupe, il est maintenant possible de contrôler et de régimer les masses en fonction de notre volonté sans qu'ils le sachent", a écrit Bernays dans «Propaganda» en 1928.

Il a convaincu le monde que le poulet à bois rapide budgétaire était "le bon doigt", que le bacon et les œufs étaient un petit-déjeuner sain et que si vous buviez de la bière à dos, vous seriez comme "l'homme le plus intéressant du monde",qui a figuré dans les annonces.La campagne les plus célèbres, les torches de la liberté des Bernays ont convaincu des millions de femmes de commencer à fumer des cigarettes en signe d'émancipation et d'indépendance.

Quand tout est mis comme ça, nous pouvons voir ce genre de chose pour ce que c'est.Le problème est que les manipulateurs ont tendance à mettre leur désinformation.

L'opinion est divisée sur la raison pour laquelle nous tombons pour elle.Certains croient que nous pensons que nous voulons penser lorsque nous rencontrons de nouveaux contenus, plutôt que d'essayer de découvrir la vérité sur le contenu.D'autres disent que nous n'exercez pas les compétences de réflexion critique, en s'appuyant sur la réponse instinctive aux informations rencontrées, en particulier lorsque vous jetez un coup d'œil sur le contenu, ou tout simplement le titre.

Ajoutez à cela ce que le fondateur de l'économie comportementale George Lowenstein a dit à propos de notre curiosité naturelle pour résoudre les lacunes de l'information - en particulier face à une question ou un puzzle qui a une réponse inconnue ou inattendue.

Ensuite, appliquez le concept du mème de Richard Brodie pour comprendre ce que ces lacunes d'information sont remplies.Brodie, l'auteur original de Microsoft Word, a écrit que tout le monde avait une collection de croyances, d'attitudes et de pensées parrain (mèmes) transmises par nos familles, notre culture et notre société.Ces mèmes influencent la façon dont nous voyons les choses et ce que nous faisons, souvent sans que nous en réalisions, et nous les transmettons à ceux qui nous entourent.

Avec tout cela à l'esprit, pensez à regarder du contenu, sur votre téléphone, tout en mangeant un sandwich, en envoyant un SMS à un ami et en écoutant de la musique.

Tristan Harris, ancien éthicien de la conception de Google et star du récent film de Netflix «Social Dilemma», qui met en garde contre les dangers d'Internet et des médias sociaux, est d'avis que la technologie numérique est utilisée pour exploiter les biais, les vulnérabilités et les limites inhérentes ànature humaine.Il peut le faire, dit-il, parce que la technologie numérique a évolué plus rapidement que le cerveau humain, ce qui reste autant que lorsque nous étions des chasseurs de chasseurs.

Harris explique que notre besoin émotionnel de validation sociale, d'approbation et d'exactitude peut créer une dépendance aux «goûts» et aux «tiques».Pour le reste du temps où nous ne nous faisons pas remarquer en ligne, nous souffrons de symptômes quasi-dédale.

C'est ce que les comportementalistes cognitifs appellent un renforcement aléatoire.La toxicomanie est alimentée par une récompense intermittente, le comportement souhaité par le manipulateur beaucoup plus susceptible de persister que si la récompense est donnée à chaque fois ou jamais donnée.C'est la même raison pour laquelle le jeu est si addictif.

Le modèle commercial de base des médias sociaux, la publicité basée sur la surveillance, capitalise sur ce.Sur les plateformes de médias sociaux, les algorithmes suivent le comportement des utilisateurs afin de vendre des annonces ciblées, mais aussi pour influencer et modifier le comportement des utilisateurs afin que nous passons plus de temps à faire défiler, à aimer, à acheter, à croire.L'idée est de déclencher des émotions, et les émotions négatives sont les plus faciles à déclencher.

C'est pourquoi nous sommes attirés par le contenu sensationnaliste attirant l'attention.Nous voulons évacuer notre colère, notre indignation, notre indignation et notre frustration et nier notre tristesse, notre culpabilité, notre honte et notre peur.Notre récompense pour partager, aimer ou commenter un tel contenu est, selon une étude de l'Université de Cambridge en juin 2021, environ deux fois plus d'engagement et donc de validation.

Ajoutez à cela, dit Harris, notre tendance à se rassembler dans des groupes aux vues similaires et à accéder à la pression sociale et il est facile de voir pourquoi le contenu provocateur et négatif favorisé par les manipulateurs en ligne a tendance à se propager plus rapidement et plus.

La réponse évidente à tout cela est de sortir des médias sociaux et de ne pas utiliser Internet à moins que vous ne vouliez envoyer un message à des amis, achetez une pizza ou vérifiez les scores de football.La plupart des gens ne peuvent pas ou ne le feront pas, en particulier pendant une pandémie de verrouillage.Mais il y a des actions qui peuvent être prises pour nous aider à gérer la désinformation manipulatrice.

Pour commencer, nous pouvons désactiver les notifications, désinstaller des applications et modifier les paramètres de confidentialité ou faire un choix conscient de ne pas afficher les publications et les vidéos suggérées par les algorithmes.

Nous pouvons également devenir plus activés sur l'utilisation du langage manipulateur.La «politique et la langue anglaise» de George Orwell présente des mots, des phrases, des métaphores utilisées pour influencer, confondre, impliquer et tromper.Lisez n'importe quoi de Bernay.

En 2020, les chercheurs du MIT ont mis en place un projet qui utilise une technologie de réalité virtuelle pour aider les gens à reconnaître la vidéo manipulée numériquement.Ils ont utilisé une vidéo truquée de Richard Nixon parlant des atterrissages de la lune, avec un acteur vocal, une technologie de parole synthétique et des techniques de remplacement de dialogue vidéo pour reproduire le mouvement de la bouche de Nixon.Cela donne l'impression qu'un discours que Nixon n'a jamais prononcé publiquement a été fait devant une caméra télévisée.L'équipe du MIT a créé un site Web éducatif et un cours, basé sur cette vidéo, pour aider les gens à comprendre comment les fausses images sont faites et utilisées pour répandre la désinformation.

«L'alphabétisation des médias aide [les gens] à cultiver leur critique intérieur, en les transformant des consommateurs passifs de médias en un public exigeant», explique le Dr Joshua Glick du MIT Documentary Lab, qui est impliqué dans le projet.

Le Dr Martin Moore, un expert en éducation à la communication politique du King's College London, est d'accord sur l'importance de l'alphabétisation des médias numériques, mais ajoute que des interventions comme celle-ci sont «les objectifs de politique à long terme et non une réponse à notre situation actuelle, ou même quelque chose quiavoir un impact au cours de la prochaine année ».

Il poursuit: «Il y a des modifications techniques qui peuvent être apportées qui auraient des effets d'entraînement sur toute la ligne."

Au Stevens Institute of Technology, les chercheurs utilisent l'apprentissage automatique pour découvrir les connexions cachées qui sous-tendent les fausses nouvelles et la désinformation des médias sociaux.

Les chercheurs ont utilisé la technologie de traitement naturel en langue naturelle pour analyser les nouvelles à partir d'ensembles de données open source plus importants, tels que Fakenewsnet, Twitter et Celebrity, et ont constaté que les phrases et les modèles de mots diffèrent dans les fausses nouvelles: un vocabulaire moins sophistiqué qui est élevé sur l'imagerie et provocateur, langue négative.Un algorithme contenant des graphiques de connaissances aide à identifier les relations entre les entités dans une fausse nouvelle comme une fausse.

Il existe plus de technologies - le filigrane et les signatures numériques, la technologie qui peut aider à expliquer comment les informations se déplacent sur Internet, les extensions de navigateur avec des services de vérification des faits ou de qualité.La personne moyenne est-elle suffisante pour y accéder?Devrions-nous le faire, lorsque le problème a été créé par les plateformes de médias sociaux et est en train de tirer parti des organisations et des individus qui les utilisent?

Une étude de l'Université du Kansas, publiée en mars 2021, a constaté que les informations signalées étaient plus susceptibles d'être examinées par les utilisateurs et que, sans notification, les gens ont eu plus de mal à identifier et à ignorer les fausses nouvelles.

Au Royaume-Uni, en vertu du projet de loi sur la sécurité en ligne du gouvernement Johnson qui devrait devenir droit plus tard cette année ou l'année prochaine, les plateformes de médias sociaux seront condamnées à une amende jusqu'à 10% de leur chiffre d'affaires mondial s'ils ne retirent pas le contenu que le gouvernement considère comme nuisibleau public.Le faux reportage de la Commission de l'UE recommande que les grandes entreprises technologiques et les autorités publiques partagent des données pour permettre une évaluation indépendante de leurs efforts pour lutter contre la désinformation.

Beaucoup souhaiteraient des modifications apportées à la façon dont le fonctionnement des plateformes de médias sociaux fonctionne.En juin, une coalition d'organisations de protection des consommateurs et de droits numériques et d'experts en Europe et aux États-Unis ont appelé les gouvernements et les plateformes de médias sociaux à prendre des mesures contre la surveillance commerciale.

Le rapport a proposé des modèles de publicité numérique alternatifs, par exemple où les annonceurs ont plus de contrôle sur l'endroit où les annonces sont présentées, ou où les consommateurs ont choisi de voir certaines publicités.Harris aimerait voir de lourdes taxes prélevées sur la pratique de l'attention monétarisante et de nouveaux services d'abonnement qui permettent et autonomisent nos vies hors ligne.Jonathan Haidt, psychologue social à la Stern School of Business de l'Université de New York, suggère que l'obscurcisse.

Haidt souhaite également que les principales plateformes insistent sur la vérification de l'identité pour les comptes d'utilisateurs et le programme de la technologie IA pour reconnaître et défier les utilisateurs lorsqu'ils publient des messages potentiellement blessants.

Le Dr Moore suggère que les plates-formes devraient nécessiter l'autorisation d'un utilisateur avant que quelqu'un ne les ajoute à un groupe et imposent plus de contraintes à l'endroit où les utilisateurs peuvent envoyer du contenu.Plus important encore, il aimerait voir plus d'identification de la source.

“You could click on a button to see the details of that post," Moore says."Vous n'auriez besoin que d'une petite proportion d'utilisateurs pour indiquer clairement quelle est la Providence, et vous auriez un écosystème sain et constructif."

En ce moment, cependant, il y a encore trop de déchets.Il suffit d'aller en ligne pendant dix minutes pour réaliser que.

Le problème est que les manipulateurs réalisent précisément ce qu'ils veulent et continueront de le faire pendant que les choses restent telles qu'elles sont.Les propriétaires de plateformes ratissent les dollars, les annonceurs vendent, des médecins de spin, des extrémistes et des théoriciens du complot influencent.

Et ce ne sont pas seulement les escrocs évidents qui sont.Lors de la recherche de cet article, je lisais un article en ligne dans un journal national qui critiquait la désinformation.Soudain, à mi-chemin de la page, une annonce est apparue.Incroyablement, il m'a demandé si je voudrais m'inscrire à un cours de marketing sur les réseaux sociaux.

Edward Bernays serait fier de ses successeurs.

Tech pour riposter

• Mauvaise nouvelle: un jeu qui expose les joueurs à de fausses tactiques d'actualités dans son rôle de faux baron.Pour gagner, publier les titres qui attirent le plus de disciples.

• Bot Sentinel: suit Twitter pour des informations et des comptes peu fiables.

• EXIFTOOL: fournit des informations de métadonnées sur la source, l'horodatage, la création d'un élément de contenu et si des modifications ont été apportées.

• Détecteur de désinformation: protocole de confiance décentralisé sur le Web qui suit la crédibilité des nouvelles, en analysant à quoi le contenu est lié et comment il est réparti (en développement).

• Twitter Trails: Algorithme Analyse Spread of a Story et comment les utilisateurs réagissent.

• Logiquement: choisit et vérifie les allégations clés dans un contenu, choisit des prises positives, négatives et neutres de chaque histoire.

• Factmata: algorithmes de compréhension contextuelle qui peuvent identifier les récits menaçants et croissants.

• Storyzy: détecte et classe les fausses sources d'information et analyse les URL et classent les sources d'information.