Tänä vuonna tuli kuluneeksi 20 vuotta, kun kirjoitin kirjan "Search Engine Marketing: The Essential Best Practice Guide". Sitä pidetään yleisesti ensimmäisenä kattavana hakukoneoptimointioppaana ja sen taustalla olevan tiedonhaun (IR) tieteenä.

Ajattelin, että olisi hyödyllistä katsoa, mitä kirjoitin vuonna 2002, jotta nähdään, miten se kehittyy nykyään. Aloitamme verkon indeksointiin liittyvistä perusnäkökohdista.

On tärkeää ymmärtää Internetin historia ja tausta ja tehdä hakuja ymmärtääksesi, missä olemme tänään ja mitä on tulossa. Ja haluan kertoa teille, että on paljon maata katettavana.

Alamme on nyt ryntäämässä uuteen Internetin iteraatioon. Aloitamme tarkastelemalla vuonna 2002 käsittelemääni pohjatyötä. Sen jälkeen tutkimme nykyhetkeä SEO:n tulevaisuuteen katsomalla muutamia tärkeitä esimerkkejä (esim. strukturoitu data, pilvilaskenta, IoT, reunalaskenta, 5G),

Kaikki tämä on valtava harppaus siitä, missä internet alkoi.

Liity minuun, eikö niin, kun kiemurtelemme hakukoneoptimoinnin muistikaistalla.

Tärkeä historian oppitunti

Käytämme termejä World Wide Web ja Internet vaihtokelpoisesti. Ne eivät kuitenkaan ole sama asia.

Yllätyt kuinka monet eivät ymmärrä eroa.

Internetin ensimmäinen iteraatio keksittiin vuonna 1966. Tiedemies Vint Cerf (tällä hetkellä Googlen johtava Internet-evankelista) keksi vuonna 1973 toisen iteration, joka toi sen lähemmäksi nykyistä tietämystä.

Maailman verkon keksi brittiläinen tiedemies Tim Berners-Lee (nykyisin Sir) 1980-luvun lopulla.

Mielenkiintoista kyllä, useimmat ihmiset ajattelevat, että hän käytti eliniän verran tieteellistä tutkimusta ja kokeilua ennen kuin hänen keksintönsä lanseerattiin. Mutta näin ei ole ollenkaan. Berners-Lee keksi internetin lounastunnillaan eräänä päivänä vuonna 1989 nauttiessaan kinkkuvoileipiä CERN-laboratorion henkilökunnan kahvilassa Sveitsissä.

Ja tämän artikkelin otsikon selkeyden lisäämiseksi seuraavasta vuodesta (1990) yksi robotti on indeksoinut verkkoa tavalla tai toisella tähän päivään (siis 32 vuotta verkkoindeksointia) .

Miksi sinun on tiedettävä tämä?

Verkon ei koskaan ollut tarkoitus tehdä sitä, mitä olemme nyt tottuneet siltä odottamaan (ja nämä odotukset kasvavat jatkuvasti).

Berners-Lee suunnitteli ja kehitti alun perin verkkoa vastatakseen automatisoidun tiedon jakamisen kysyntään yliopistojen ja instituuttien tutkijoiden välillä ympäri maailman.

Joten suuri osa siitä, mitä yritämme saada webin tekemään, on vierasta keksijälle ja selaimelle (jonka myös Berners-Lee keksi).

Ja tämä on erittäin tärkeää hakukoneiden skaalautuvuuden suuriin haasteisiin, kun ne yrittävät kerätä sisältöä indeksoitavaksi ja pysymään tuoreena samalla kun yrittävät löytää ja indeksoida uutta sisältöä.

Hakukoneet eivät voi käyttää koko verkkoa

On selvää, että verkkoon sisältyi luontaisia haasteita. Ja tämä tuo minut toiseen erittäin tärkeään seikkaan, joka on korostettava.

Se on "läpivaltainen myytti", joka sai alkunsa, kun Google lanseerattiin ensimmäisen kerran, ja näyttää olevan yhtä laajalle levinnyt nyt kuin silloin. Ja se on ihmisten uskomus, että Googlella on pääsy koko verkkoon.

Ei. Ei totta. Itse asiassa ei lähellekään sitä.

Kun Google aloitti verkkoindeksoinnin vuonna 1998, sen hakemistossa oli noin 25 miljoonaa yksilöllistä URL-osoitetta. Kymmenen vuotta myöhemmin, vuonna 2008, he ilmoittivat saavuttaneensa merkittävän virstanpylvään, koska he ovat nähneet 1 biljoonaa ainutlaatuista URL-osoitetta verkossa.

Olen viime aikoina nähnyt lukuja, joiden mukaan Google on tietoinen noin 50 biljoonasta URL-osoitteesta. Mutta tässä on suuri ero, joka meidän hakukoneoptimoijien on tiedettävä:

Ja 50 biljoonaa on paljon URL-osoitteita. Mutta tämä on vain pieni osa koko verkosta.

Google (tai mikä tahansa muu hakukone) voi indeksoida valtavan määrän sisältöä verkon pinnalta. Mutta "syväverkossa" on myös valtava määrä sisältöä, johon indeksointirobotit eivät yksinkertaisesti pääse käsiksi. Se on lukittu rajapintojen taakse, mikä johtaa valtavaan tietokantasisältöön. Kuten korostin vuonna 2002, indeksointiroboteissa ei ole näyttöä ja näppäimistöä!

Lisäksi 50 biljoonaa yksilöllistä URL-osoitetta on mielivaltainen. Minulla ei ole aavistustakaan, mikä Googlen todellinen luku tällä hetkellä on (eikä heillä itsekään ole aavistustakaan siitä, kuinka monta sivua maailmanlaajuisessa verkossa todella on).

Nämä URL-osoitteet eivät myöskään johda ainutlaatuiseen sisältöön. Verkko on täynnä roskapostia, päällekkäistä sisältöä, iteratiivisia linkkejä ei minnekään ja kaikenlaista muuta verkkoroskaa.

Hakukonearkkitehtuurin ymmärtäminen

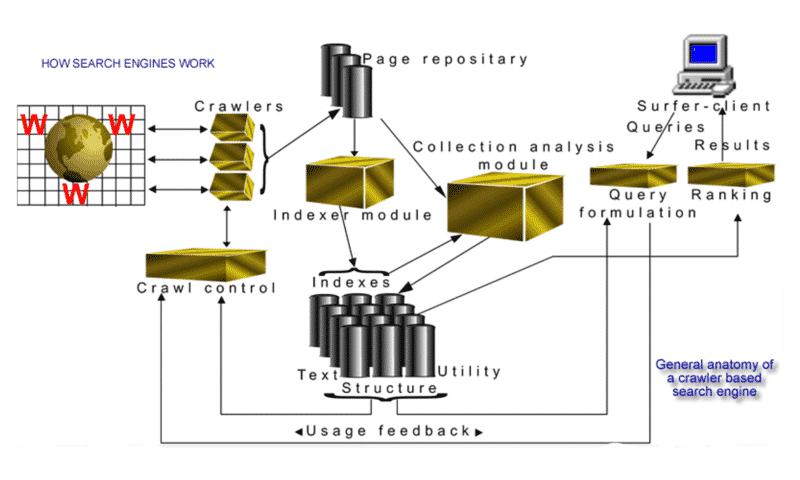

Vuonna 2002 loin visuaalisen tulkinnan "indeksointipohjaisen hakukoneen yleisestä anatomiasta":

On selvää, että tämä kuva ei ansainnut minulle graafisen suunnittelun palkintoja. Mutta se oli tarkka osoitus siitä, kuinka verkkohakukoneen eri osat yhdistyivät vuonna 2002. Se varmasti auttoi nousevaa SEO-teollisuutta saamaan paremman käsityksen siitä, miksi ala ja sen käytännöt olivat niin tarpeellisia.

Vaikka hakukoneiden käyttämät tekniikat ovat kehittyneet huomattavasti (ajattele: tekoäly/koneoppiminen), tärkeimmät tekijät, prosessit ja taustalla oleva tiede pysyvät samoina.

Vaikka termit "koneoppiminen" ja "tekoäly" ovat löytäneet tiensä useammin alan sanakirjaan viime vuosina, kirjoitin tämän hakukoneen anatomiaa käsittelevään osioon 20 vuotta sitten:

"Tämän osion lopuksi käsittelen "oppimiskoneita" (vektoritukilaitteita) ja tekoälyä (AI), jossa verkkohaun ja -haun alan on väistämättä mentävä seuraavaksi."

Uuden sukupolven hakukoneiden indeksointirobotit

On vaikea uskoa, että kaikkialla planeetalla on kirjaimellisesti vain kourallinen verkkoa indeksoivia yleiskäyttöisiä hakukoneita, joista Google on (väistämättä) suurin. Sanon sen, koska vuonna 2002 oli kymmeniä hakukoneita, ja uusia startupeja lähes joka viikko.

Koska olen usein tekemisissä paljon nuorempien alan ammattilaisten kanssa, minusta on silti hauskaa, etteivät monet edes ymmärrä, että hakukoneoptimointi oli olemassa ennen kuin Google oli olemassa.

Vaikka Google saa paljon kiitosta innovatiivisesta tavasta lähestyä verkkohakua, se oppi paljon Brian Pinkertonilta. Minulla oli onni haastatella Pinkertonia (useammin kuin kerran).

Hän on maailman ensimmäisen WebCrawler-nimisen kokotekstinhakukoneen keksijä. Ja vaikka hän oli aikaansa edellä hakuteollisuuden kynnyksellä, hän nauroi kanssani, kun hän selitti ensimmäisen verkkohakukoneen asennuksensa. Se toimi yhdellä 486-koneella, jossa oli 800 Mt levyä ja 128 Mt muistia ja yksi indeksointirobotti, joka lataa ja tallentaa sivuja vain 6 000 verkkosivustolta!

Hieman erilainen kuin mitä kirjoitin Googlesta vuonna 2002 "uuden sukupolven" hakukoneena, joka indeksoi verkkoa.

"Sanaa "indeksoija" käytetään melkein aina yksikössä; Useimmissa hakukoneissa on kuitenkin itse asiassa useita indeksointirobotteja, joiden agenttien "laivasto" tekee työtä massiivisessa mittakaavassa. Esimerkiksi Google uuden sukupolven hakukoneena aloitti neljällä indeksointirobotilla, joista jokainen piti auki noin kolmesataa yhteyttä. Huippunopeuksilla he latasivat tietoa yli sadalta sivulta sekunnissa. Google (kirjoitushetkellä) luottaa nyt 3 000 Linux-tietokoneeseen, joissa on yli 90 teratavua levytilaa. He lisäävät palvelinfarmiinsa kolmekymmentä uutta konetta päivässä vain pysyäkseen kasvun tahdissa.

Ja Googlen skaalaus- ja kasvukuvio on jatkunut vauhdilla sen kirjoittamisen jälkeen. Siitä on aikaa, kun näin tarkan luvun, mutta ehkä muutama vuosi sitten näin arvion, että Google indeksoi 20 miljardia sivua päivässä. Se on todennäköisesti vielä enemmän kuin nyt.

Hyperlinkkianalyysi ja indeksointi/indeksointi/koko verkon ongelma

Voiko sijoittua Googlen 10 parhaan joukkoon, jos sivuasi ei ole koskaan indeksoitu?

Niin epätodennäköiseltä kuin kysymyksessä saattaakin tuntua, vastaus on "kyllä". Ja taas, se on jotain, jota kosketin kirjassani vuonna 2002:

Google palauttaa ajoittain luettelon tai jopa yhden linkin dokumenttiin, jota ei ole vielä indeksoitu, mutta ilmoittaa, että asiakirja näkyy vain, koska avainsanat esiintyvät muissa linkeillä varustetuissa asiakirjoissa, jotka osoittavat se.

Mistä siinä on kyse? Kuinka tämä on mahdollista?

Hyperlinkkianalyysi. Joo, se on käänteisiä linkkejä!

Indeksoinnin, indeksoinnin ja yksilöllisten URL-osoitteiden tunnistamisen välillä on ero. Tässä on lisäselvitys, jonka annoin:

"Jos palaat Internetin indeksoimista käsittelevässä osiossa kuvattuihin valtaviin haasteisiin, on selvää, ettei koskaan pidä olettaa, että KAIKKI sivustosi sivut on indeksoitu hakukonehämähäkin käynnin jälkeen. . Minulla on asiakkaita, joilla on eri sivumääräisiä verkkosivustoja. Noin viisikymmentä, noin 5000, ja rehellisesti sanottuna voin sanoa, ettei yhdelläkään heistä ole jokaista sivua indeksoinut jokainen suuri hakukone. Kaikilla suurimmilla hakukoneilla on URL-osoitteet indeksoinnin "rajalla", kuten se tunnetaan, eli indeksointirobotin hallinnassa on usein miljoonia URL-osoitteita tietokannassa, joiden olemassaolo se tietää, mutta joita ei ole vielä indeksoitu ja ladattu.

Olen monta kertaa nähnyt esimerkkejä tästä. Kymmenen parhaan tuloksen kyselyn jälkeen näyttäisi joskus perus-URL-osoitteen ilman otsikkoa tai katkelmaa (tai metatietoja).

Tässä on esimerkki, jota käytin esityksessä vuodelta 2004. Katso alinta tulosta, niin ymmärrät mitä tarkoitan.

Google on tietoinen sivun tärkeydestä sitä ympäröivien linkitystiedon vuoksi. Sivulta ei kuitenkaan ole vedetty tukitietoja, ei edes otsikkotunnistetta, koska sivu on ilmeisesti tehnyt ei ryömitty. (Tietenkin tämä voi tapahtua myös ikivihreässä yhä-aina-ajan pikkuvirheessä, kun joku jättää robots.txt-tiedoston estääkseen sivuston indeksoinnin.)

Korrostin tämän lauseen lihavoituna kahdesta tärkeästä syystä:

Koristan "kohteliaisuutta" hieman enemmän, koska se on suoraan yhteydessä robots.txt-tiedostoon/protokollaan. Kaikki verkon indeksointiin liittyvät haasteet, jotka selitin 20 vuotta sitten, ovat edelleen olemassa (suuremmassa mittakaavassa).

Koska indeksointirobotit hakevat tietoja huomattavasti nopeammin ja syvemmällä kuin ihmiset, niillä voi (ja joskus on) olla lamauttava vaikutus verkkosivuston suorituskykyyn. Palvelimet voivat kaatua vain yrittäessään pysyä nopeiden pyyntöjen määrässä.

Siksi vaaditaan kohteliaisuuspolitiikkaa, jota ohjaavat toisaalta indeksointirobotin ohjelmointi ja indeksoinnin juoni ja toisaalta robots.txt-tiedosto.

Mitä nopeammin hakukone pystyy indeksoimaan uuden indeksoitavan sisällön ja indeksoimaan hakemistossa olevat sivut uudelleen, sitä tuoreempaa sisältö on.

Saatko tasapainon oikein? Se on se vaikein osa.

Oletetaan puhtaasti hypoteettisesti, että Google halusi pitää uutiset ja ajankohtaiset asiat kattavasti ja päätti yrittää indeksoida koko New York Times -sivuston joka päivä (jopa joka viikko) ilman mitään kohteliaisuustekijöitä. On todennäköistä, että indeksointirobotti käyttäisi kaiken kaistanleveyden. Ja se merkitsisi sitä, että kukaan ei pääse lukemaan lehtiä verkossa kaistanleveyden vuoksi.

Onneksi nyt meillä on vain kohteliaisuuden lisäksi Google Search Console, jossa on mahdollista manipuloida verkkosivustojen indeksointinopeutta ja -tiheyttä.

Mikä on muuttunut 32 vuoden verkkoindeksoinnin aikana?

Okei, olemme käsittäneet paljon, kuten tiesinkin.

Sekä Internetiin että verkkoon on varmasti tehty monia muutoksia – mutta indeksointia näyttävät edelleen haittaavan samat vanhat ongelmat.

Näin jokin aika sitten Andrey Kolobovin, Bingin koneoppimisen alan tutkijan esityksen. Hän loi algoritmin tasapainottamaan kaistanleveyttä, kohteliaisuutta ja tärkeyttä indeksoitaessa.

Minusta se oli erittäin informatiivinen, yllättävän suoraviivainen ja melko helposti selitetty. Vaikka et ymmärtäisi matematiikkaa, älä huoli, saat silti viitteitä siitä, kuinka hän ratkaisee ongelman. Ja kuulet myös sanan "tärkeys" sekoituksessa uudelleen.

Periaatteessa, kuten selitin aiemmin indeksoinnin rajalla olevista URL-osoitteista, hyperlinkkien analysointi on tärkeää ennen indeksointia, ja se voi hyvinkin olla syy siihen, kuinka nopeasti indeksointi onnistuu. Voit katsoa lyhyen videon hänen esityksestään täältä.

Katsotaanpa nyt, mitä Internetissä tapahtuu juuri nyt ja kuinka verkko, internet, 5G ja parannetut sisältömuodot kehittyvät.

Strukturoitu data

Verkko on ollut alusta asti jäsentämätöntä dataa. Näin se keksittiin. Ja koska se kasvaa edelleen eksponentiaalisesti joka päivä, hakukoneiden haasteena on indeksoida ja indeksoida uudelleen olemassa olevia hakemistossa olevia asiakirjoja analysoidakseen ja päivittääkseen, onko hakemistoon tehty muutoksia, jotta hakemisto pysyy tuoreena.

Se on valtava tehtävä.

Olisi paljon helpompaa, jos tiedot olisi jäsennelty. Ja niin paljon siitä itse asiassa on, koska jäsennellyt tietokannat ohjaavat niin monia verkkosivustoja. Mutta sisältö ja esitys ovat tietysti erillään, koska sisältö on julkaistava puhtaasti HTML:nä.

Olen ollut tietoinen vuosien varrella monista yrityksistä, joissa on rakennettu mukautettuja poimijoita, joilla yritetään muuntaa HTML:ää strukturoiduksi tiedoksi. Mutta enimmäkseen nämä yritykset olivat erittäin hauraita operaatioita, melko työläitä ja täysin virhealttiita.

Muu, joka on muuttanut pelin täysin, on se, että verkkosivustot koodattiin alkuaikoina käsin ja suunniteltiin kömpelöille vanhoille pöytäkoneille. Mutta nyt web-sivujen hakemiseen käytettyjen eri muototekijöiden määrä on muuttanut suuresti esitysmuotoja, joihin verkkosivustojen on kohdistettava.

Kuten sanoin, verkkoon liittyvien haasteiden vuoksi Googlen kaltaiset hakukoneet eivät todennäköisesti koskaan pysty indeksoimaan koko verkkoa.

Joten, mikä olisi vaihtoehtoinen tapa parantaa prosessia huomattavasti? Entä jos annamme indeksointirobotin jatkaa tavanomaista työtään ja tarjoamme strukturoidun tietosyötteen samanaikaisesti saataville?

Viime vuosikymmenen aikana tämän idean merkitys ja hyödyllisyys ovat kasvaneet ja kasvaneet. Monille se on vielä uusi idea. Mutta jälleen kerran, Pinkerton, WebCrawlerin keksijä, oli paljon edellä tässä asiassa 20 vuotta sitten.

Hän ja minä keskustelimme ajatuksesta verkkotunnuskohtaisista XML-syötteistä syntaksin standardoimiseksi. XML oli tuolloin uutta ja sitä pidettiin selainpohjaisen HTML:n tulevaisuutena.

Sitä kutsutaan laajennettavaksi, koska se ei ole kiinteä muoto, kuten HTML. XML on "metakieli" (muiden kielten kuvaamiseen tarkoitettu kieli, jonka avulla voit suunnitella omia mukautettuja sivunkuvauskieliä rajattomasti erilaisille asiakirjoille). Useita muita lähestymistapoja kehuttiin HTML:n tulevaisuudeksi, mutta ne eivät täyttäneet vaadittua yhteentoimivuutta.

Yksi lähestymistapa, joka sai paljon huomiota, tunnetaan kuitenkin nimellä MCF (Meta Content Framework), joka esitteli ideoita tiedon esittämisen alalta (kehykset ja semanttiset verkot). Ajatuksena oli luoda yhteinen tietomalli suunnatun leimatun graafin muodossa.

Kyllä, idea tunnetaan paremmin semanttisena verkkona. Ja mitä juuri kuvailin, on tietograafin varhainen näkemys. Se ajatus on muuten vuodelta 1997.

Kaiken tämän jälkeen kaikki alkoi sujua vuonna 2011, ja schema.orgin perustivat Bing, Google, Yahoo ja Yandex. Ajatuksena oli esitellä webmastereille yksi sanasto. Eri hakukoneet saattavat käyttää merkintöjä eri tavalla, mutta verkkovastaavien täytyi tehdä työ vain kerran, ja he hyötyisivät useiden merkintöjen käyttäjistä.

OK – en halua eksyä liian pitkälle strukturoidun datan valtavaan merkitykseen hakukoneoptimoinnin tulevaisuuden kannalta. Sen täytyy olla oma artikkelinsa. Palaan siis asiaan toisen kerran tarkemmin.

Näet kuitenkin luultavasti, että jos Google ja muut hakukoneet eivät pysty indeksoimaan koko verkkoa, strukturoidun tiedon syöttäminen, jotta sivut päivitetään nopeasti ilman, että niitä tarvitsee indeksoida uudelleen toistuvasti, on valtava ero.

Ja tämä on erityisen tärkeää, sinun on silti tunnistettava jäsentämätön tietosi E-A-T (asiantuntemus, arvovalta, luotettavuus) -tekijöiden perusteella, ennen kuin strukturoitu data todella käynnistyy.

Pilvipalvelu

Kuten olen jo käsitellyt, internet on viimeisten neljän vuosikymmenen aikana kehittynyt vertaisverkosta maailmanlaajuisen verkon päällekkäiseksi mobiili-internet-vallankumoukseksi. Pilvilaskenta, esineiden internet, Edge Computing ja 5G.

Siirtymä kohti pilvilaskentaa antoi meille alan ilmaisun "Internetin pilvistyminen".

Valtavat varaston kokoiset palvelinkeskukset tarjoavat palveluita tietojenkäsittelyn, tallennuksen, verkottumisen, tiedonhallinnan ja ohjauksen hallintaan. Tämä tarkoittaa usein sitä, että Cloud-palvelinkeskukset sijaitsevat lähellä esimerkiksi vesivoimaloita tarjoamaan tarvitsemansa valtavan määrän tehoa.

Reunalaskenta

Nyt "Internetin reunamuokkaus" kääntää kaiken takaisin kauempaa käyttäjälähteestä sen viereen.

Edge computing tarkoittaa fyysisiä laitteistolaitteita, jotka sijaitsevat etäisissä paikoissa verkon reunalla ja joissa on riittävästi muistia, prosessointitehoa ja laskentaresursseja tietojen keräämiseen, käsittelemiseen ja suorittamiseen lähes reaaliajassa rajoitetun tuen avulla. verkon muihin osiin.

Kun laskentapalvelut sijoitetaan lähemmäs näitä paikkoja, käyttäjät hyötyvät nopeammista, luotettavammista palveluista ja paremmista käyttökokemuksista, ja yritykset hyötyvät pystyvänsä paremmin tukemaan latenssiherkkiä sovelluksia, tunnistamaan trendejä ja tarjoamaan erittäin korkealaatuisia tuotteita ja palveluita. IoT-laitteita ja Edge-laitteita käytetään usein vaihtokelpoisina.

5G

5G:n sekä IoT:n ja Edge-tietotekniikan ansiosta myös sisällön luonti- ja jakelutapa muuttuu dramaattisesti.

Näemme jo virtuaalitodellisuuden (VR) ja lisätyn todellisuuden (AR) elementtejä kaikenlaisissa erilaisissa sovelluksissa. Ja haussa se ei ole erilainen.

AR-kuvat ovat luonnollinen aloite Googlelle, ja he ovat nyt parin vuoden ajan pelleilleet 3D-kuvien kanssa vain testaamassa, testaamassa ja testaamassa. Mutta jo nyt he yhdistävät tämän alhaisen viiveen pääsyn tietokaavioon ja tuovat sisältöä visuaalisesti houkuttelevammilla tavoilla.

Pandemian huipulla nyt "digitaalisesti kiihdytetty" loppukäyttäjä tottui käyttämään Googlen tulosten sekoitukseen lisäämiä 3D-kuvia. Aluksi se oli eläimiä (koiria, karhuja, haita) ja sitten autoja.

Viime vuonna Google ilmoitti, että tuona aikana 3D-tulokset olivat vuorovaikutuksessa yli 200 miljoonaa kertaa. Tämä tarkoittaa, että rima on asetettu, ja meidän kaikkien on alettava ajatella näiden rikkaampien sisältökokemusten luomista, koska loppukäyttäjä (ehkä seuraava asiakkaasi) odottaa jo tämän parannetun sisällön tarjontaa.

Jos et ole vielä kokenut sitä itse (ja kaikki eivät edes toimialallamme ole kokeneet), tässä on hieno herkku. Tässä viime vuoden videossa Google esittelee kuuluisia urheilijoita AR-sekoitukseen. Ja supertähtiurheilija Simone Biles saa olla vuorovaikutuksessa AR-itsensä kanssa hakutuloksissa.

IoT

Internetin eri vaiheet/kehitysvaiheet selvitettyäsi ei ole vaikea sanoa, että kaikki tavalla tai toisella yhteydessä oleva on tulevaisuuden liikkeellepaneva voima.

Teknologioiden saaman edistyneen hypetyksen vuoksi on helppo hylätä se ajatuksilla, kuten esim. IoT on vain älykkäitä hehkulamppuja ja puettavat laitteet ovat vain kuntoilulaitteita ja kelloja. Mutta maailmaa ympärilläsi muokataan asteittain tavoilla, joita tuskin osaat kuvitella. Se ei ole tieteiskirjallisuutta.

IoT ja puettavat laitteet ovat kaksi nopeimmin kasvavista teknologioista ja kuumimmista tutkimusaiheista, jotka laajentavat valtavasti kulutuselektroniikan sovelluksia (erityisesti viestintää).

Tulevaisuus ei ole myöhässä saapuessaan tällä kertaa. Se on jo täällä.

Elämme verkossa toimivassa maailmassa, jossa miljardit tietokoneet, tabletit, älypuhelimet, puettavat laitteet, pelikonsolit ja jopa lääketieteelliset laitteet, jopa kokonaiset rakennukset, käsittelevät ja toimittavat tietoa digitaalisesti.

Tässä on mielenkiintoinen pieni fakta sinulle: on arvioitu, että IoT:hen yhdistettyjen laitteiden ja kohteiden määrä peittää jo maan päällä olevien ihmisten määrän.

Takaisin hakukoneoptimoinnin tulevaisuuteen

Lopetetaan tähän. Mutta paljon lisää tulossa.

Aion eritellä sen, mitä nykyään tunnemme hakukoneoptimoinnina, kuukausittain julkaistavissa artikkeleissa, joissa käsitellään perusnäkökohtia. Vaikka termi "SEO" ei tullut sanakirjaan vähään aikaan, kun 1990-luvun puolivälissä ja loppupuolella alkoi ilmaantua mökkiteollisuus, jossa "hakukoneportaaleista löydetään asioita".

Siihen asti – ole terve, ole tuottava ja ota kaikki ympärilläsi näinä jännittävinä teknologia-aikoina. Palaan muutaman viikon kuluttua lisää.

Tässä artikkelissa esitetyt mielipiteet ovat vierailevan kirjoittajan mielipiteitä, eivät välttämättä Search Engine Landin mielipiteitä. Henkilökunnan kirjoittajat on lueteltu tässä.