Etiquetar datos puede ser una tarea. Es la principal fuente de sustento para los modelos de visión por computadora; sin él, tendrían muchas dificultades para identificar objetos, personas y otras características importantes de la imagen. Sin embargo, producir solo una hora de datos etiquetados y etiquetados puede llevar la friolera de 800 horas de tiempo humano. Nuestra comprensión de alta fidelidad del mundo se desarrolla a medida que las máquinas pueden percibir e interactuar mejor con nuestro entorno. Pero necesitan más ayuda.

Científicos del Laboratorio de Ciencias de la Computación e Inteligencia Artificial (CSAIL) del MIT, Microsoft y la Universidad de Cornell han intentado resolver este problema que afecta a los modelos de visión mediante la creación de "STEGO", un algoritmo que puede descubrir y segmentar objetos sin etiquetas humanas en forma conjunta. todo, hasta el píxel.

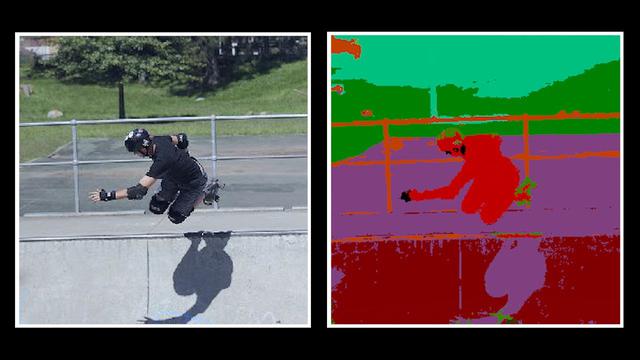

STEGO aprende algo llamado "segmentación semántica", un lenguaje elegante para el proceso de asignar una etiqueta a cada píxel de una imagen. La segmentación semántica es una habilidad importante para los sistemas de visión por computadora de hoy en día porque las imágenes pueden estar abarrotadas de objetos. Aún más desafiante es que estos objetos no siempre encajan en cajas literales; los algoritmos tienden a funcionar mejor para "cosas" discretas como personas y automóviles en lugar de "cosas" como vegetación, cielo y puré de papas. Un sistema anterior podría simplemente percibir una escena matizada de un perro jugando en el parque como un perro, pero al asignar una etiqueta a cada píxel de la imagen, STEGO puede dividir la imagen en sus ingredientes principales: un perro, cielo, hierba y su dueno.