Reprogramación de ese robot implica etiquetar a mano miles de imágenes que le muestran cómo comprender estas nuevas tazas, luego entrenar el sistema nuevamente.

Pero una nueva técnica desarrollada por los investigadores del MIT requeriría solo un puñado de manifestaciones humanas para reprogramar el robot.Este método de aprendizaje automático permite que un robot recoja y coloque objetos nunca antes vistos que están en posturas aleatorias que nunca ha encontrado.En 10 a 15 minutos, el robot estaría listo para realizar una nueva tarea de selección y lugar.

La técnica utiliza una red neuronal diseñada específicamente para reconstruir las formas de los objetos 3D.Con solo unas pocas demostraciones, el sistema utiliza lo que la red neuronal ha aprendido sobre la geometría 3D para comprender los objetos nuevos que son similares a los de las demostraciones.

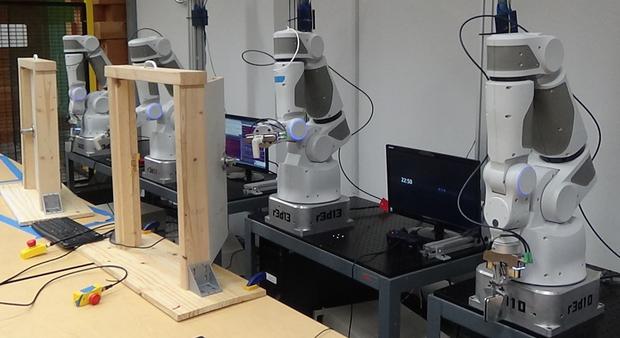

En las simulaciones y el uso de un brazo robótico real, los investigadores muestran que su sistema puede manipular efectivamente tazas, tazones y botellas de manera efectiva, organizadas en poses aleatorias, utilizando solo 10 demostraciones para enseñar al robot.

"Nuestra principal contribución es la capacidad general de proporcionar nuevas habilidades a los robots que necesitan operar en entornos más no estructurados donde podría haber mucha variabilidad.El concepto de generalización por construcción es una capacidad fascinante porque este problema suele ser mucho más difícil ", dice Anthony Simeonov, estudiante de posgrado en Ingeniería Eléctrica y Ciencias de la Computación (EEC) y co-líder del documento.

advertisementSimeonov escribió el periódico con el co-autor Yilun Du, un estudiante graduado de las CEE;Andrea Tagliasacchi, científica de investigación del personal en Google Brain;Joshua B.Tenenbaum, el Paul E.Profesor de desarrollo profesional de Newton de ciencia cognitiva y cálculo en el Departamento de Ciencias Cognitivas y Cognitivas y miembro del Laboratorio de Informática e Inteligencia Artificial (CSAIL);Alberto Rodríguez, profesor asociado de clase de 1957 en el Departamento de Ingeniería Mecánica;y autores principales Pulkit Agrawal, profesor de CSAIL, y Vincent Sitzmann, profesor asistente entrante en EECS.La investigación se presentará en la Conferencia Internacional sobre Robótica y Automatización..

Geometría de agarre

Un robot puede ser entrenado para recoger un elemento específico, pero si ese objeto está de lado (tal vez se cayó), el robot ve esto como un escenario completamente nuevo.Esta es una razón por la que es tan difícil para los sistemas de aprendizaje automático generalizar a nuevas orientaciones de objetos.

Para superar este desafío, los investigadores crearon un nuevo tipo de modelo de red neuronal, un campo descriptor neuronal (NDF), que aprende la geometría 3D de una clase de elementos.El modelo calcula la representación geométrica para un elemento específico utilizando una nube de puntos 3D, que es un conjunto de puntos de datos o coordenadas en tres dimensiones.Los puntos de datos se pueden obtener de una cámara de profundidad que proporciona información sobre la distancia entre el objeto y un punto de vista.Si bien la red fue entrenada en simulación en un gran conjunto de datos de formas 3D sintéticas, se puede aplicar directamente a los objetos en el mundo real.

El equipo diseñó el NDF con una propiedad conocida como equivalencia.Con esta propiedad, si el modelo se muestra una imagen de una taza vertical, y luego se muestra una imagen de la misma taza en su lado, entiende que la segunda taza es el mismo objeto, simplemente girado.

advertisement"Esta equivalencia es lo que nos permite manejar mucho más efectivamente los casos en que el objeto que observa está en alguna orientación arbitraria", dice Simeonov.

A medida que el NDF aprende a reconstruir formas de objetos similares, también aprende a asociar partes relacionadas de esos objetos.Por ejemplo, aprende que las manijas de las tazas son similares, incluso si algunas tazas son más altas o más anchas que otras, o tienen manijas más pequeñas o más largas.

"Si quisieras hacer esto con otro enfoque, tendrías que etiquetar a mano todas las partes.En cambio, nuestro enfoque descubre automáticamente estas partes de la reconstrucción de la forma ", dice Du dice.

Los investigadores usan este modelo NDF capacitado para enseñarle a un robot una nueva habilidad con solo unos pocos ejemplos físicos.Mueven la mano del robot a la parte de un objeto que quieren que se agarre, como el borde de un tazón o el mango de una taza, y registran las ubicaciones de las yemas de los dedos.

Debido a que el NDF ha aprendido mucho sobre la geometría 3D y cómo reconstruir formas, puede inferir la estructura de una nueva forma, lo que permite al sistema transferir las demostraciones a nuevos objetos en poses arbitrarias, explica Du..

Elegir un ganador

Probaron su modelo en simulaciones y en un brazo robótico real con tazas, tazones y botellas como objetos.Su método tenía una tasa de éxito del 85 por ciento en tareas de selección y lugar con nuevos objetos en nuevas orientaciones, mientras que la mejor línea de base solo pudo lograr una tasa de éxito del 45 por ciento.El éxito significa comprender un nuevo objeto y colocarlo en una ubicación objetivo, como colgar tazas en un estante.

Muchas líneas de base usan información de imagen 2D en lugar de geometría 3D, lo que dificulta que estos métodos integren la equivalencia.Esta es una de las razones por las que la técnica NDF funcionó mucho mejor.

Si bien los investigadores estaban contentos con su desempeño, su método solo funciona para la categoría de objetos particular en la que está capacitado.Un robot que se enseña a recoger tazas no podrá recoger cajas o auriculares, ya que estos objetos tienen características geométricas que son demasiado diferentes a lo que la red estaba entrenada.

"En el futuro, ampliarlo a muchas categorías o dejar ir por completo la noción de categoría sería ideal", dice Simeonov.

También planean adaptar el sistema para objetos no rígidas y, a largo plazo, permiten que el sistema realice tareas de selección y lugar cuando cambia el área de destino.

Este trabajo es apoyado, en parte, por la Agencia de Proyectos de Investigación Avanzada de Defensa, la Agencia de Ciencia y Tecnología de la Defensa de Singapur y la National Science Foundation.