Letos před 20 lety jsem napsal knihu s názvem „Marketing ve vyhledávačích: Průvodce základními osvědčenými postupy“. Je obecně považován za prvního komplexního průvodce SEO a základní vědou o vyhledávání informací (IR).

Říkal jsem si, že by bylo užitečné podívat se na to, co jsem napsal v roce 2002, abych zjistil, jak je na tom dnes. Začneme základními aspekty toho, co obnáší procházení webu.

Je důležité porozumět historii a pozadí internetu a vyhledávat, abyste pochopili, kde jsme dnes a co bude dál. A řeknu vám, že je toho hodně, co je potřeba pokrýt.

Naše odvětví se nyní řítí do další nové iterace internetu. Začneme revizí základů, kterými jsem se zabýval v roce 2002. Poté prozkoumáme současnost s ohledem na budoucnost SEO, podíváme se na několik důležitých příkladů (např. strukturovaná data, cloud computing, IoT, edge computing, 5G),

To vše je obrovský skok od místa, kde internet začal.

Připojte se ke mně, ne, když se kloužeme po paměťové lince optimalizace pro vyhledávače.

Důležitá lekce historie

Pojmy world wide web a internet používáme zaměnitelně. Nejsou však totéž.

Byli byste překvapeni, kolik lidí ten rozdíl nechápe.

První iterace internetu byla vynalezena v roce 1966. Další iteraci, která jej přiblížila tomu, co známe nyní, vynalezl v roce 1973 vědec Vint Cerf (v současnosti hlavní internetový evangelista pro Google).

World Wide Web vynalezl britský vědec Tim Berners-Lee (nyní Sir) koncem 80. let 20. století.

Zajímavé je, že většina lidí má představu, že předtím, než byl jeho vynález uveden na trh, strávil něco ekvivalentního k celoživotnímu vědeckému výzkumu a experimentování. Ale tak to vůbec není. Berners-Lee jednoho dne v roce 1989 během obědové hodiny vynalezl world wide web, když si pochutnával na šunkovém sendviči v kavárně pro zaměstnance v laboratoři CERN ve Švýcarsku.

A aby byl nadpis tohoto článku trochu jasnější, od následujícího roku (1990) web prochází tak či onak tím či oním robotem až do dnešních dnů (tedy 32 let procházení webu) .

Proč to všechno potřebujete vědět

Web nikdy neměl dělat to, co od něj nyní očekáváme (a tato očekávání se neustále zvyšují).

Berners-Lee původně vymyslel a vyvinul web, aby uspokojil poptávku po automatizovaném sdílení informací mezi vědci na univerzitách a ústavech po celém světě.

Velká část toho, co se snažíme přimět web, je vynálezci a prohlížeči (který vynalezl také Berners-Lee) cizí.

A to je velmi důležité pro hlavní výzvy škálovatelnosti, se kterou se vyhledávače potýkají ve snaze sklízet obsah, aby jej indexoval a udržovat jej aktuální, a zároveň se snaží objevovat a indexovat nový obsah.

Vyhledávače nemají přístup k celému webu

Je zřejmé, že celosvětový web přišel s neodmyslitelnými problémy. A to mě přivádí k další nesmírně důležité skutečnosti, kterou je třeba zdůraznit.

Je to „všudypřítomný mýtus“, který začal při prvním spuštění společnosti Google a zdá se, že je nyní stejně všudypřítomný jako tehdy. A to je přesvědčení lidí, že Google má přístup k celému webu.

Ne. Není pravda. Vlastně nikde poblíž.

Když Google v roce 1998 poprvé začal procházet web, měl jeho index přibližně 25 milionů unikátních adres URL. O deset let později, v roce 2008, oznámili, že dosáhli hlavního milníku, kdy na webu viděli 1 bilion unikátních adres URL.

V poslední době jsem viděl čísla naznačující, že Google zná asi 50 bilionů adres URL. Ale tady je velký rozdíl, který my všichni SEO potřebujeme vědět:

A 50 bilionů je spousta adres URL. Ale to je jen nepatrný zlomek celého webu.

Google (nebo jakýkoli jiný vyhledávač) může procházet obrovské množství obsahu na povrchu webu. Na „hlubokém webu“ je ale také obrovské množství obsahu, ke kterému prohledávače jednoduše nemají přístup. Je uzamčen za rozhraními, která vedou ke kolosálnímu množství obsahu databáze. Jak jsem zdůraznil v roce 2002, prohledávače nejsou vybaveny monitorem a klávesnicí!

Také počet 50 bilionů unikátních adres URL je libovolný. Nemám ponětí, jaká je skutečná hodnota v Google právě teď (a ani oni sami nemají ponětí o tom, kolik stránek na celosvětové síti skutečně je).

Všechny tyto adresy URL také nevedou k jedinečnému obsahu. Web je plný spamu, duplicitního obsahu, opakujících se odkazů nikam a všemožných dalších druhů webového odpadu.

Porozumění architektuře vyhledávače

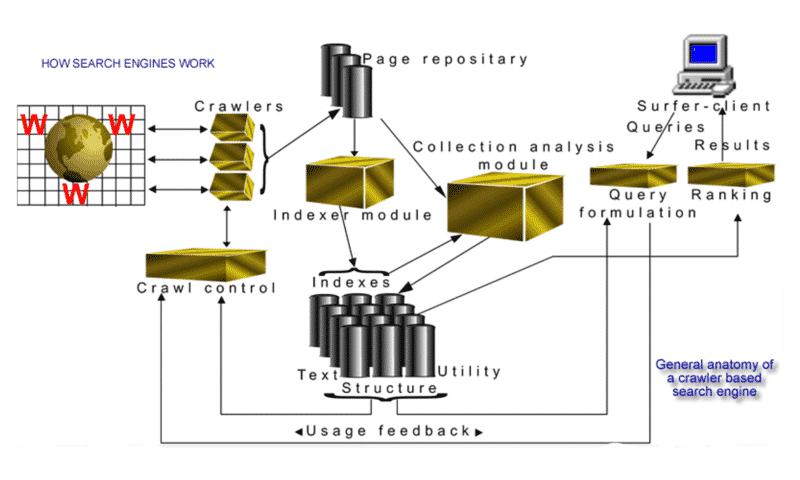

V roce 2002 jsem vytvořil vizuální interpretaci „obecné anatomie vyhledávače založeného na prohledávači“:

Je zřejmé, že tento obrázek mi nezískal žádná ocenění za grafický design. Byla to však přesná indikace toho, jak se v roce 2002 spojily různé součásti webového vyhledávače. Určitě to pomohlo vznikajícímu odvětví SEO získat lepší přehled o tom, proč je toto odvětví a jeho postupy tak nezbytné.

Přestože technologie používané vyhledávači značně pokročily (umělá inteligence/strojové učení), hlavní hnací síly, procesy a základní věda zůstávají stejné.

Přestože termíny „strojové učení“ a „umělá inteligence“ si v posledních letech našly cestu do oborového lexikonu častěji, napsal jsem to v sekci o anatomii vyhledávače před 20 lety:

„Na závěr této části se dotknu ‚učebních strojů‘ (stroje na podporu vektorů) a umělé inteligence (AI), což je oblast, kde se musí oblast vyhledávání a načítání na webu nevyhnutelně ubírat dál.“

Prohledávače pro vyhledávače nové generace

Je těžké uvěřit, že na celém světě existuje doslova jen hrstka univerzálních vyhledávačů, které procházejí web, přičemž Google (pravděpodobně) je největší. Říkám to proto, že v roce 2002 existovaly desítky vyhledávačů a téměř každý týden přicházely nové startupy.

Vzhledem k tomu, že se často setkávám s mnohem mladšími odborníky v oboru, stále mi připadá zábavné, že si mnozí ani neuvědomují, že SEO existovalo dříve, než byl Google.

Přestože Google získává velkou zásluhu za inovativní způsob, jakým přistupoval k vyhledávání na webu, hodně se naučil od muže jménem Brian Pinkerton. Měl jsem to štěstí udělat rozhovor s Pinkertonem (při více než jedné příležitosti).

Je vynálezcem prvního fulltextového vyhledávače na světě s názvem WebCrawler. A přestože předběhl svou dobu na úsvitu vyhledávacího průmyslu, dobře se se mnou zasmál, když vysvětloval své první nastavení pro webový vyhledávač. Běžel na jediném stroji 486 s 800 MB disku a 128 MB paměti a jediným prohledávačem stahujícím a ukládajícím stránky z pouhých 6 000 webových stránek!

Poněkud odlišné od toho, co jsem napsal o Google v roce 2002 jako o vyhledávači „nové generace“, který prochází web.

„Slovo ‚crawler‘ se téměř vždy používá v jednotném čísle; nicméně většina vyhledávačů má ve skutečnosti řadu prohledávačů s „flotilou“ agentů provádějících práci v masivním měřítku. Například Google jako vyhledávač nové generace začal se čtyřmi prohledávači, z nichž každý udržoval otevřené asi tři stovky připojení. Při maximální rychlosti stahovaly informace z více než stovky stránek za sekundu. Google (v době psaní tohoto článku) nyní spoléhá na 3 000 počítačů se systémem Linux s více než devadesáti terabajty diskového úložiště. Do své serverové farmy přidávají třicet nových strojů denně, jen aby udrželi krok s růstem.“

Od doby, kdy jsem to napsal, tento vzorec růstu a rozšiřování ve společnosti Google pokračuje rychlým tempem. Je to už nějakou dobu, co jsem viděl přesné číslo, ale možná před pár lety jsem viděl odhad, že Google prochází 20 miliard stránek denně. Teď je to pravděpodobně ještě víc.

Analýza hypertextových odkazů a hlavolam týkající se procházení/indexování/celého webu

Je možné se na Googlu umístit mezi 10 nejlepšími, pokud vaše stránka nebyla nikdy procházena?

Ač se to v dotazu může zdát nepravděpodobné, odpověď je „ano“. A znovu, je to něco, čeho jsem se dotkl v roce 2002 v knize:

Čas od času Google vrátí seznam nebo dokonce jeden odkaz na dokument, který ještě nebyl prolezen, ale s upozorněním, že se dokument zobrazuje pouze proto, že klíčová slova se objevují v jiných dokumentech s odkazy, které odkazují na to.

O co jde? Jak je tohle možné?

Analýza hypertextových odkazů. Ano, to jsou zpětné odkazy!

Je rozdíl mezi procházením, indexováním a pouhým povědomím o jedinečných adresách URL. Zde je další vysvětlení, které jsem uvedl:

„Pokud se vrátíte k obrovským výzvám nastíněným v části o procházení webu, je jasné, že po návštěvě z vyhledávače by se nemělo nikdy předpokládat, že VŠECHNY stránky na vašem webu byly indexovány . Mám klienty s weby různého stupně co do počtu stránek. Nějakých padesát, nějakých 5000 a se vší upřímností mohu říci, že ani jeden z nich nemá každou stránku indexovanou každým velkým vyhledávačem. Všechny velké vyhledávače mají adresy URL na „hranici“ procházení, jak je známo, tj. kontrola prohledávače bude mít v databázi často miliony adres URL, o kterých ví, že existují, ale ještě nebyly prolezeny a staženy.“

Mnohokrát jsem viděl takové příklady. U 10 nejlepších výsledků následujících po dotazu se někdy zobrazí základní adresa URL bez názvu nebo úryvku (nebo metadat).

Zde je příklad, který jsem použil v prezentaci z roku 2004. Podívejte se na spodní výsledek a uvidíte, co tím myslím.

Google si je vědom důležitosti této stránky kvůli datům o propojení, které ji obklopují. Ze stránky však nebyly staženy žádné podpůrné informace, dokonce ani značka title, protože stránka zjevně ano. nebyl prolezen. (Samozřejmě k tomu může dojít také v případě stále zeleného, stále se opakujícího malého omylu, kdy někdo opustí soubor robots.txt, který brání procházení webu.)

Tuto větu jsem výše zvýraznil tučně ze dvou důležitých důvodů:

Tu „slušnost“ jen trochu přikrášlím, protože je přímo propojena se souborem/protokolem robots.txt. Všechny problémy spojené s procházením webu, které jsem vysvětlil před 20 lety, stále existují (ve větším měřítku).

Protože prohledávače získávají data mnohem rychleji a rychleji než lidé, mohly by (a někdy mají) mít ochromující dopad na výkon webu. Servery mohou selhat, jen když se snaží držet krok s počtem požadavků s vysokou rychlostí.

Proto jsou vyžadovány zásady zdvořilosti, které se na jedné straně řídí naprogramováním prohledávače a zákresem procházení a na druhé straně souborem robots.txt.

Čím rychleji může vyhledávač procházet nový obsah, který má být indexován, a znovu procházet existující stránky v indexu, tím aktuálnější bude obsah.

Dosahujete správné rovnováhy? To je ta nejtěžší část.

Řekněme, čistě hypoteticky, že Google chtěl zachovat důkladné pokrytí zpráv a aktuálních událostí a rozhodl se pokusit procházet celý web New York Times každý den (dokonce každý týden) bez jakéhokoli zdvořilostního faktoru. Je velmi pravděpodobné, že prohledávač využije celou jejich šířku pásma. A to by znamenalo, že nikdo nemůže číst noviny online kvůli šířce pásma.

Naštěstí nyní máme kromě zdvořilosti k dispozici Google Search Console, kde je možné manipulovat s rychlostí a frekvencí procházení webových stránek.

Co se za 32 let procházení webu změnilo?

Dobře, prošli jsme spoustu věcí, jak jsem věděl.

Určitě došlo k mnoha změnám na internetu i na celosvětové síti – ale zdá se, že procházení stále brání stejné staré problémy.

Před chvílí jsem viděl prezentaci Andrey Kolobova, výzkumníka v oblasti strojového učení ve společnosti Bing. Vytvořil algoritmus, který při vykreslování procházení vyvažuje problém se šířkou pásma, zdvořilostí a důležitostí.

Zjistil jsem, že je velmi informativní, překvapivě přímočarý a docela snadno vysvětlitelný. I když nerozumíte matematice, žádný strach, stále získáte náznak, jak se s problémem vypořádá. A také v mixu znovu uslyšíte slovo „důležitost“.

V zásadě, jak jsem již dříve vysvětlil o adresách URL na hranici procházení, je před procházením důležitá analýza hypertextových odkazů. Ve skutečnosti může být důvodem toho, jak rychle budete prohledáni. Na krátké video z jeho prezentace se můžete podívat zde.

Nyní se podívejme na to, co se právě teď děje s internetem a jak se vyvíjí web, internet, 5G a vylepšené formáty obsahu.

Strukturovaná data

Web byl od začátku velkým množstvím nestrukturovaných dat. Tak to bylo vymyšleno. A protože stále roste exponenciálně každý den, výzvou pro vyhledávače je procházet a znovu procházet existující dokumenty v indexu, aby analyzovaly a aktualizovaly, pokud byly provedeny nějaké změny, aby index zůstal aktuální.

Je to obrovský úkol.

Bylo by mnohem jednodušší, kdyby byla data strukturovaná. A ve skutečnosti je toho tolik, protože strukturované databáze řídí tolik webových stránek. Ale obsah a prezentace jsou samozřejmě odděleny, protože obsah musí být publikován čistě v HTML.

V průběhu let jsem si byl vědom mnoha pokusů, kdy byly vytvořeny vlastní extraktory, aby se pokusily převést HTML na strukturovaná data. Většinou však šlo o velmi křehké operace, poměrně pracné a zcela náchylné k chybám.

Něco jiného, co hru zcela změnilo, je to, že webové stránky byly v prvních dnech ručně kódovány a navrženy pro staré neohrabané stolní počítače. Nyní však množství různých tvarových faktorů používaných k načítání webových stránek výrazně změnilo formáty prezentací, na které se webové stránky musí zaměřit.

Jak jsem řekl, vzhledem k problémům, které web přináší, vyhledávače jako Google pravděpodobně nikdy nebudou schopny procházet a indexovat celý světový web.

Jaký by tedy byl alternativní způsob, jak tento proces výrazně zlepšit? Co když necháme prohledávač pokračovat ve své běžné práci a současně zpřístupníme zdroj strukturovaných dat?

Za poslední desetiletí význam a užitečnost této myšlenky rostly a rostly. Pro mnohé je to stále docela nová myšlenka. Ale opět Pinkerton, vynálezce WebCrawler, byl v tomto tématu před 20 lety daleko napřed.

On a já jsme diskutovali o myšlence zdrojů XML specifických pro doménu ke standardizaci syntaxe. V té době byl XML nový a považoval se za budoucnost HTML založeného na prohlížeči.

Nazývá se rozšiřitelný, protože se nejedná o pevný formát jako HTML. XML je „metalanguage“ (jazyk pro popis jiných jazyků, který vám umožňuje navrhovat si vlastní přizpůsobené značkovací jazyky pro neomezené množství různých typů dokumentů). Různé další přístupy byly vychvalovány jako budoucnost HTML, ale nemohly splnit požadovanou interoperabilitu.

Nicméně jeden přístup, který si získal velkou pozornost, je známý jako MCF (Meta Content Framework), který představil myšlenky z oblasti reprezentace znalostí (rámce a sémantické sítě). Myšlenkou bylo vytvořit společný datový model ve formě orientovaného označeného grafu.

Ano, tato myšlenka se stala známější jako sémantický web. A to, co jsem právě popsal, je raná vize znalostního grafu. Ta myšlenka pochází z roku 1997, mimochodem.

Vše bylo v roce 2011, kdy se vše začalo slučovat a schema.org byla založena společnostmi Bing, Google, Yahoo a Yandex. Cílem bylo prezentovat webmasterům jednotnou slovní zásobu. Různé vyhledávače mohou používat značky odlišně, ale webmasteři museli tuto práci provést pouze jednou a mohli by sklízet výhody u více spotřebitelů značky.

OK – nechci příliš zabíhat do obrovského významu strukturovaných dat pro budoucnost SEO. To musí být samostatný článek. Takže se k tomu podrobně vrátím jindy.

Pravděpodobně však vidíte, že pokud Google a další vyhledávače nedokážou procházet celý web, význam dodávání strukturovaných dat, která jim pomáhá rychle aktualizovat stránky, aniž by je museli opakovaně procházet, znamená obrovský rozdíl.

Vzhledem k tomu, a to je obzvláště důležité, stále potřebujete, aby vaše nestrukturovaná data byla rozpoznána z hlediska jejich faktorů E-A-T (odbornost, autoritativnost, důvěryhodnost), než se strukturovaná data skutečně rozběhnou.

Cloud computing

Jak jsem se již zmínil, za poslední čtyři desetiletí se internet vyvinul ze sítě peer-to-peer přes celosvětovou síť k revoluci mobilního internetu, Cloud computing, internet věcí, Edge Computing a 5G.

Posun směrem ke cloud computingu nám dal průmyslovou frázi „cloudifikace internetu“.

Obrovská datová centra o velikosti skladu poskytují služby pro správu výpočetní techniky, úložiště, sítě, správu a kontrolu dat. To často znamená, že cloudová datová centra se nacházejí například v blízkosti vodních elektráren, aby poskytovala obrovské množství energie, kterou potřebují.

Edge computing

Nyní, „Edgeifacation of the internet“ to všechno změní z dálky od uživatelského zdroje na to, aby byl hned vedle něj.

Edge computing je o fyzických hardwarových zařízeních umístěných ve vzdálených místech na okraji sítě s dostatkem paměti, výpočetního výkonu a výpočetních zdrojů pro sběr dat, zpracování těchto dat a jejich spouštění téměř v reálném čase s omezenou pomocí ostatní části sítě.

Umístěním počítačových služeb blíže k těmto lokalitám mohou uživatelé těžit z rychlejších a spolehlivějších služeb s lepšími uživatelskými zkušenostmi a společnosti těží z toho, že budou moci lépe podporovat aplikace citlivé na latenci, identifikovat trendy a nabízet mnohem lepší produkty a služby. Zařízení IoT a zařízení Edge se často používají zaměnitelně.

5G

S 5G a výkonem IoT a Edge computingu se dramaticky změní i způsob vytváření a distribuce obsahu.

Prvky virtuální reality (VR) a rozšířené reality (AR) již vidíme ve všech druzích různých aplikací. A ve vyhledávání tomu nebude jinak.

Snímky AR jsou pro Google přirozenou iniciativou a už několik let si s 3D obrázky pohrává, jen testuje, testuje a testuje. Ale již tento přístup s nízkou latencí ke znalostnímu grafu začleňují a přinášejí obsah vizuálně působivějšími způsoby.

Během vrcholu pandemie si nyní „digitálně zrychlený“ koncový uživatel zvykl na 3D obrázky, které Google sypal do směsi výsledků. Nejprve to byla zvířata (psi, medvědi, žraloci) a poté auta.

Loni Google oznámil, že během tohoto období došlo k více než 200milionové interakci mezi 3D výsledky. To znamená, že laťka byla nastavena a my všichni musíme začít přemýšlet o vytvoření těchto bohatších obsahových zážitků, protože koncový uživatel (možná váš další zákazník) již očekává tento vylepšený typ obsahu.

Pokud jste to na vlastní kůži ještě nezažili (a ne každý, dokonce ani v našem oboru), máme pro vás skvělou lahůdku. V tomto videu z minulého roku Google zavádí slavné sportovce do mixu AR. A superstar atletka Simone Bilesová může ve výsledcích vyhledávání interagovat se svým AR já.

IoT

Po zavedení různých fází/vývojů internetu není těžké říci, že vše, co je tak či onak propojeno, bude hnací silou budoucnosti.

Vzhledem k pokročilému humbuku, kterému se mnoho technologií dostává, je snadné jej zavrhnout myšlenkami, že IoT je jen o chytrých žárovkách a nositelná zařízení jsou jen o fitness trackerech a hodinkách. Ale svět kolem vás se postupně přetváří způsobem, který si jen stěží dokážete představit. Není to sci-fi.

IoT a nositelná zařízení jsou dvě z nejrychleji rostoucích technologií a nejžhavější výzkumná témata, která výrazně rozšíří aplikace spotřební elektroniky (zejména komunikace).

Budoucnost tentokrát nepřichází pozdě. už je to tady.

Žijeme v propojeném světě, kde miliardy počítačů, tabletů, chytrých telefonů, nositelných zařízení, herních konzolí a dokonce i lékařských zařízení, a dokonce celé budovy, digitálně zpracovávají a doručují informace.

Tady je pro vás zajímavý malý fakt: odhaduje se, že počet zařízení a položek připojených k internetu věcí již převyšuje počet lidí na Zemi.

Zpět do budoucnosti SEO

Zde se zastavíme. Ale ještě mnohem víc.

Mám v plánu rozebrat to, co nyní známe jako optimalizace pro vyhledávače, v sérii měsíčních článků, které se zabývají základními aspekty. Ačkoli termín „SEO“ nějakou dobu nevstoupil do slovníku, protože od poloviny do konce devadesátých let se začal objevovat domácký průmysl „dělat věci, abyste je našli na portálech vyhledávačů“.

Do té doby – mějte se dobře, buďte produktivní a absorbujte vše kolem vás v této vzrušující technologické době. Za pár týdnů se vrátím s dalšími.

Názory vyjádřené v tomto článku jsou názory hostujícího autora a ne nutně Search Engine Land. Autoři zaměstnanců jsou uvedeni zde.