Тази година се навършиха 20 години, когато написах книга, наречена „Маркетинг в търсачки: Основното ръководство за най-добри практики“. Обикновено се смята за първото цялостно ръководство за SEO и основната наука за извличане на информация (IR).

Мислех, че ще е полезно да погледна какво съм написал през 2002 г., за да видя как се подрежда днес. Ще започнем с основните аспекти на това, което е свързано с обхождането на мрежата.

Важно е да разберете историята и фона на интернет и търсенето, за да разберете къде сме днес и какво предстои. И нека ви кажа, има много неща за покриване.

Нашата индустрия сега се втурва към нова итерация на интернет. Ще започнем с преглед на основата, която разгледах през 2002 г. След това ще проучим настоящето, с поглед към бъдещето на SEO, като разгледаме няколко важни примера (напр. структурирани данни, облачни изчисления, IoT, периферни изчисления, 5G),

Всичко това е мега скок от началото на интернет.

Присъединете се към мен, нали, докато лъкатушим по алеята на паметта за оптимизиране на търсачките.

Важен урок по история

Ние използваме термините световна мрежа и интернет като взаимозаменяеми. Те обаче не са едно и също нещо.

Ще се изненадате колко хора не разбират разликата.

Първата итерация на интернет е изобретена през 1966 г. Допълнителна итерация, която го доближава до това, което познаваме сега, е изобретена през 1973 г. от учения Винт Серф (понастоящем главен интернет евангелист на Google).

Световната мрежа е изобретена от британския учен Тим Бърнърс-Лий (сега сър) в края на 80-те години.

Интересното е, че повечето хора имат представата, че той е прекарал нещо, равностойно на цял живот в научни изследвания и експерименти, преди изобретението му да бъде пуснато на пазара. Но това изобщо не е така. Бърнърс-Лий изобретява световната мрежа по време на обяда си един ден през 1989 г., докато се наслаждава на сандвич с шунка в кафенето на служителите в лабораторията на CERN в Швейцария.

И за да внесем малко яснота в заглавието на тази статия, от следващата година (1990 г.) мрежата е била обхождана по един или друг начин от един или друг бот до наши дни (следователно 32 години обхождане на мрежата) .

Защо трябва да знаете всичко това

Мрежата никога не е била предназначена да прави това, което сега сме свикнали да очакваме от нея (и тези очаквания постоянно се увеличават).

Бърнърс-Лий първоначално замисли и разработи мрежата, за да отговори на търсенето на автоматизирано споделяне на информация между учени в университети и институти по целия свят.

Така че голяма част от това, което се опитваме да направим в мрежата, е чуждо на изобретателя и браузъра (който Бърнърс-Лий също е изобретил).

И това е много подходящо за основните предизвикателства на мащабируемостта, които търсачките имат в опитите си да съберат съдържание, за да го индексират и поддържат актуално, в същото време като се опитват да открият и индексират ново съдържание.

Търсачките нямат достъп до цялата мрежа

Ясно е, че световната мрежа дойде с присъщи предизвикателства. И това ме води до друг изключително важен факт, който трябва да подчертая.

Това е „широко разпространеният мит“, който започна, когато Google стартира за първи път и изглежда е толкова широко разпространен сега, колкото беше и тогава. И това е убеждението на хората, че Google има достъп до цялата мрежа.

Не. Не е вярно. Всъщност никъде близо до него.

Когато Google за първи път започна да обхожда мрежата през 1998 г., неговият индекс беше около 25 милиона уникални URL адреса. Десет години по-късно, през 2008 г., те обявиха, че са достигнали основния крайъгълен камък като са видели 1 трилион уникални URL адреса в мрежата.

Съвсем наскоро видях числа, които предполагат, че Google знае за около 50 трилиона URL адреса. Но ето голямата разлика, която всички ние, SEO специалистите, трябва да знаем:

А 50 трилиона са много URL адреси. Но това е само малка част от цялата мрежа.

Google (или всяка друга търсачка) може да обходи огромно количество съдържание на повърхността на мрежата. Но има и огромно количество съдържание в „дълбоката мрежа“, до което роботите просто не могат да получат достъп. Той е заключен зад интерфейси, което води до колосални количества съдържание на база данни. Както подчертах през 2002 г., роботите не са оборудвани с монитор и клавиатура!

Също така цифрата от 50 трилиона уникални URL адреса е произволна. Нямам представа каква е истинската цифра в Google в момента (и те самите нямат представа колко страници наистина има в световната мрежа).

Тези URL адреси също не водят до уникално съдържание. Мрежата е пълна със спам, дублирано съдържание, повтарящи се връзки към никъде и всякакви други видове уеб отпадъци.

Разбиране на архитектурата на търсачката

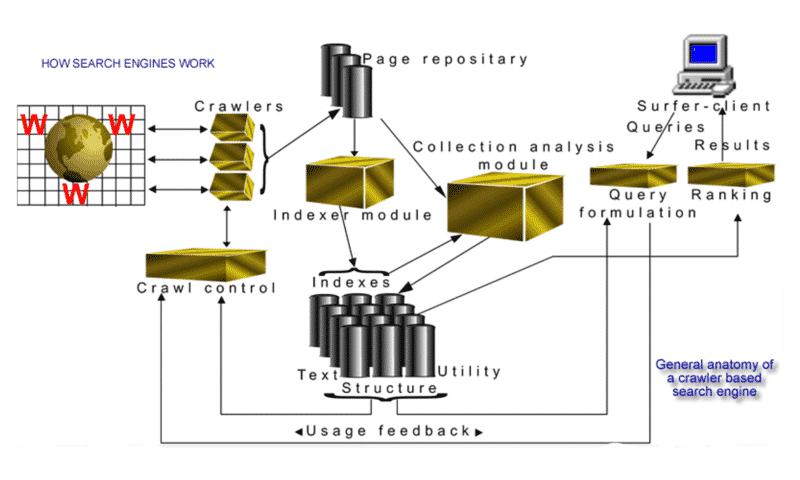

През 2002 г. създадох визуална интерпретация на „общата анатомия на търсачка, базирана на обхождане“:

Ясно е, че това изображение не ми спечели никакви награди за графичен дизайн. Но това беше точна индикация за това как различните компоненти на една уеб търсачка се събраха през 2002 г. Това със сигурност помогна на нововъзникващата SEO индустрия да придобие по-добра представа защо индустрията и нейните практики са толкова необходими.

Въпреки че технологиите, използвани от търсачките, са напреднали значително (помислете: изкуствен интелект/машинно обучение), основните двигатели, процеси и основната наука остават същите.

Въпреки че термините „машинно обучение“ и „изкуствен интелект“ са намерили своето място по-често в индустриалния лексикон през последните години, написах това в раздела за анатомията на търсачката преди 20 години:

„В заключение на този раздел ще засегна „обучаващи се машини“ (машини за векторна поддръжка) и изкуствен интелект (AI), което е мястото, където областта на търсенето и извличането в мрежата неизбежно трябва да продължи.“

Обхождащи търсачки от „ново поколение“

Трудно е да се повярва, че има буквално само шепа търсачки с общо предназначение по цялата планета, които обхождат мрежата, като Google (вероятно) е най-голямата. Казвам го, защото през 2002 г. имаше десетки търсачки с нови стартиращи компании почти всяка седмица.

Тъй като често общувам с много по-млади практици в индустрията, все още намирам за забавно, че мнозина дори не осъзнават, че SEO е съществувало преди да се появи Google.

Въпреки че Google получава голяма заслуга за новаторския подход към търсенето в мрежата, той научи много от човек на име Браян Пинкертън. Имах късмета да интервюирам Пинкертън (повече от един път).

Той е изобретателят на първата в света търсачка за извличане на пълен текст, наречена WebCrawler. И въпреки че беше изпреварил времето си в зората на индустрията за търсене, той се посмя добре с мен, когато обясни първата си настройка за уеб търсачка. Работеше на една машина 486 с 800 MB диск и 128 MB памет и един робот, изтеглящ и съхранявайки страници от само 6000 уебсайта!

Донякъде различно от това, което написах за Google през 2002 г. като търсачка от „ново поколение“, обхождаща мрежата.

„Думата „краулер“ почти винаги се използва в единствено число; въпреки това, повечето търсачки всъщност имат редица роботи с „флотиля“ от агенти, които извършват работата в огромен мащаб. Например Google, като търсачка от ново поколение, започна с четири робота, всеки от които поддържаше отворени около триста връзки. При пикови скорости те изтеглят информация от над сто страници в секунда. Google (към момента на писане) сега разчита на 3000 компютъра, работещи с Linux, с повече от деветдесет терабайта дисково пространство. Те добавят тридесет нови машини на ден към своята сървърна ферма, само за да поддържат растежа.“

И този модел на мащабиране и растеж в Google продължава с темпове, откакто написах това. Измина известно време, откакто видях точна цифра, но може би преди няколко години видях оценка, че Google обхожда 20 милиарда страници на ден. Вероятно е дори повече от това сега.

Анализ на хипервръзки и загадката за обхождане/индексиране/цялата мрежа

Възможно ли е да се класирате в топ 10 на Google, ако страницата ви никога не е била обхождана?

Колкото и невероятно да изглежда в въпроса, отговорът е „да“. И отново, това е нещо, което засегнах през 2002 г. в книгата:

От време на време Google ще върне списък или дори една връзка към документ, който все още не е обходен, но с известие, че документът се появява само защото ключовите думи се появяват в други документи с връзки, които сочат към то.

За какво става въпрос? Как е възможно?

Анализ на хипервръзки. Да, това са обратни връзки!

Има разлика между обхождане, индексиране и просто познаване на уникалните URL адреси. Ето допълнителното обяснение, което дадох:

„Ако се върнете към огромните предизвикателства, описани в раздела за обхождане на мрежата, ясно е да видите, че човек никога не трябва да приема, след посещение от паяк на търсачката, че ВСИЧКИ страници във вашия уебсайт са били индексирани . Имам клиенти с уебсайтове с различна степен на брой страници. Около петдесет, около 5000 и с пълна честност, мога да кажа, че нито една от тях няма всяка страница, индексирана от всяка голяма търсачка. Всички основни търсачки имат URL адреси на „границата“ на обхождането, както е известно, т.е. контролът на обхождането често ще има милиони URL адреси в базата данни, за които знае, че съществуват, но все още не са обходени и изтеглени.“

Много пъти съм виждал примери за това. Първите 10 резултата след заявка понякога биха имали показан основен URL адрес без заглавие или фрагмент (или метаданни).

Ето пример, който използвах в презентация от 2004 г. Погледнете долния резултат и ще разберете какво имам предвид.

Google е наясно с важността на тази страница поради данните за връзки около нея. Но от страницата не е изтеглена подкрепяща информация, дори тага за заглавие, тъй като страницата очевидно не е не е обходен. (Разбира се, това може да се случи и с вечнозелената малка грешка, която все още се случва през цялото време, когато някой напусне файла robots.txt, предотвратявайки обхождането на сайта.)

Откроих това изречение по-горе с удебелен шрифт поради две важни причини:

Просто ще разкрася малко повече „учтивостта“, тъй като е пряко свързано с файла/протокола robots.txt. Всички предизвикателства пред обхождането на мрежата, които обясних преди 20 години, все още съществуват днес (в по-голям мащаб).

Тъй като роботите извличат данни с много по-голяма скорост и дълбочина от хората, те биха могли (и понякога имат) да окажат осакатяващо въздействие върху ефективността на уебсайта. Сървърите могат да се сринат, просто опитвайки се да се справят с броя на бързите заявки.

Ето защо е необходима политика за учтивост, управлявана от една страна от програмирането на робота и графиката на обхождането, а от друга страна от файла robots.txt.

Колкото по-бързо търсачката може да обходи ново съдържание, за да бъде индексирано, и да обходи отново съществуващите страници в индекса, толкова по-свежо ще бъде съдържанието.

Постигате ли правилния баланс? Това е трудната част.

Да кажем, чисто хипотетично, че Google искаше да поддържа изчерпателно отразяване на новините и текущите събития и реши да се опита да обходи целия уебсайт на New York Times всеки ден (дори всяка седмица) без никакъв фактор за учтивост. Най-вероятно роботът ще използва цялата им честотна лента. И това би означавало, че никой не може да чете вестника онлайн поради ограничение на честотната лента.

За щастие сега, освен само фактора на учтивостта, имаме Google Search Console, където е възможно да се манипулира скоростта и честотата на обхождането на уебсайтовете.

Какво се промени за 32 години обхождане на мрежата?

Добре, покрихме много, както знаех, че ще направим.

Със сигурност има много промени както в интернет, така и в световната мрежа – но обхождащата част все още изглежда възпрепятствана от същите стари проблеми.

Въпреки това преди известно време видях презентация на Андрей Колобов, изследовател в областта на машинното обучение в Bing. Той създаде алгоритъм за извършване на балансиращ акт с честотната лента, учтивостта и проблема с важността при начертаване на обхождането.

Намерих го много информативен, изненадващо ясен и доста лесно обяснен. Дори и да не разбирате математиката, не се притеснявайте, пак ще получите индикация как той се справя с проблема. Освен това отново ще чуете думата „важност“ в микса.

По принцип, както обясних по-рано за URL адресите на границата на обхождането, анализът на хипервръзките е важен, преди да бъдете обходени, наистина може да е причината колко бързо да бъдете обходени. Можете да гледате кратко видео от представянето му тук.

Сега нека приключим с това, което се случва с интернет в момента и как мрежата, интернет, 5G и подобрените формати на съдържание се развиват.

Структурирани данни

Мрежата е море от неструктурирани данни от самото начало. Това е начинът, по който е измислено. И тъй като той все още расте експоненциално всеки ден, предизвикателството пред търсачките е да обхождат и преобхождат съществуващи документи в индекса, за да анализират и актуализират дали са направени промени, за да поддържат индекса актуален.

Това е огромна задача.

Би било много по-лесно, ако данните бяха структурирани. И голяма част от това всъщност е така, тъй като структурираните бази данни управляват толкова много уебсайтове. Но съдържанието и представянето са разделени, разбира се, защото съдържанието трябва да бъде публикувано само в HTML.

Има много опити, за които знам през годините, при които са създадени персонализирани екстрактори, за да се опитат да конвертират HTML в структурирани данни. Но най-вече тези опити бяха много крехки операции, доста трудоемки и напълно податливи на грешки.

Нещо друго, което напълно промени играта е, че уебсайтовете в ранните дни бяха ръчно кодирани и проектирани за тромавите стари настолни машини. Но сега броят на различните форм-фактори, използвани за извличане на уеб страници, значително промени форматите за представяне, към които уебсайтовете трябва да са насочени.

Както казах, поради присъщите предизвикателства на мрежата, търсачки като Google едва ли някога ще могат да обхождат и индексират цялата световна мрежа.

И така, какъв би бил алтернативният начин за значително подобряване на процеса? Какво ще стане, ако оставим роботът да продължи да върши обичайната си работа и едновременно с това направим достъпен канал за структурирани данни?

През последното десетилетие важността и полезността на тази идея нарастват и нарастват. За мнозина това все още е доста нова идея. Но, отново, Пинкертън, изобретателят на WebCrawler, беше много напред по този въпрос преди 20 години.

Той и аз обсъдихме идеята за специфични за домейни XML канали за стандартизиране на синтаксиса. По това време XML беше нов и се смяташе за бъдещето на базирания на браузър HTML.

Нарича се разширяем, защото не е фиксиран формат като HTML. XML е „метаезик“ (език за описание на други езици, който ви позволява да проектирате свои собствени персонализирани езици за маркиране за неограничено разнообразие от типове документи). Различни други подходи бяха възхвалявани като бъдещето на HTML, но не можаха да отговорят на необходимата оперативна съвместимост.

Въпреки това, един подход, който привлече много внимание, е известен като MCF (Meta Content Framework), който въвежда идеи от областта на представянето на знания (рамки и семантични мрежи). Идеята беше да се създаде общ модел на данни под формата на насочена етикетирана графика.

Да, идеята стана по-известна като семантична мрежа. И това, което току-що описах, е ранната визия на графиката на знанието. Тази идея датира от 1997 г., между другото.

Като каза всичко това, беше 2011 г., когато всичко започна да се събира, като schema.org беше основан от Bing, Google, Yahoo и Yandex. Идеята беше да се представи на уеб администраторите един речник. Различните търсачки може да използват маркирането по различен начин, но уебмастърите трябваше да свършат работата само веднъж и ще извлекат ползите от множество потребители на маркирането.

ОК – не искам да се отклонявам твърде далеч в огромното значение на структурираните данни за бъдещето на SEO. Това трябва да е отделна статия. Така че ще се върна към него друг път в подробности.

Но вероятно можете да видите, че ако Google и другите търсачки не могат да обхождат цялата мрежа, значението на подаването на структурирани данни, за да им се помогне бързо да актуализират страниците, без да се налага да ги обхождат многократно, прави огромна разлика.

Имайки предвид това, и това е особено важно, вие все още трябва да разпознаете неструктурираните си данни за техните E-A-T (експертиза, авторитетност, надеждност) фактори, преди структурираните данни наистина да започнат.

Облачни изчисления

Както вече споменах, през последните четири десетилетия интернет еволюира от peer-to-peer мрежа до наслагване на световната мрежа до революция в мобилния интернет, Облачни изчисления, Интернет на нещата, Edge Computing и 5G.

Преминаването към облачни изчисления ни даде индустриалната фраза „облачната обработка на интернет“.

Огромни центрове за данни с размер на склад предоставят услуги за управление на компютри, съхранение, работа в мрежа, управление на данни и контрол. Това често означава, че облачните центрове за данни са разположени близо до водноелектрически централи, например, за да осигурят огромното количество енергия, от което се нуждаят.

Edge computing

Сега „Edgeifacation на интернет“ връща всичко обратно от това да е по-далеч от потребителския източник до това да е точно до него.

Edge computing е свързан с физически хардуерни устройства, разположени на отдалечени места в края на мрежата с достатъчно памет, процесорна мощност и изчислителни ресурси за събиране на данни, обработка на тези данни и изпълнение в почти реално време с ограничена помощ от други части на мрежата.

Чрез разполагането на компютърни услуги по-близо до тези местоположения, потребителите се възползват от по-бързи, по-надеждни услуги с по-добро потребителско изживяване, а компаниите се възползват от това, че са в състояние по-добре да поддържат чувствителни към забавяне приложения, да идентифицират тенденциите и да предлагат изключително превъзходни продукти и услуги. IoT устройствата и Edge устройствата често се използват взаимозаменяемо.

5G

С 5G и силата на IoT и Edge изчисленията начинът, по който се създава и разпространява съдържанието, също ще се промени драматично.

Вече виждаме елементи на виртуална реалност (VR) и разширена реалност (AR) във всички видове различни приложения. И в търсенето няма да е по-различно.

AR изображенията са естествена инициатива за Google и те се забъркват с 3D изображения от няколко години, само тестват, тестват, тестват, както правят. Но те вече включват този достъп с ниска латентност до графиката на знанието и въвеждат съдържание по по-визуално завладяващи начини.

По време на разгара на пандемията сега „цифрово ускореният“ краен потребител свикна да се ангажира с 3D изображенията, които Google впръскваше в микса от резултати. Първо бяха животни (кучета, мечки, акули), а след това автомобили.

Миналата година Google обяви, че през този период триизмерните представени резултати са взаимодействали повече от 200 милиона пъти. Това означава, че летвата е поставена и всички ние трябва да започнем да мислим за създаването на тези по-богати изживявания със съдържание, защото крайният потребител (може би следващият ви клиент) вече очаква този подобрен тип съдържание.

Ако все още не сте го изпитали сами (и не всеки дори в нашата индустрия го е направил), ето едно много страхотно удоволствие. В това видео от миналата година Google въвежда известни спортисти в AR микса. А суперзвездата Симоне Байлс може да взаимодейства със себе си в AR в резултатите от търсенето.

IoT

След установяването на различните фази/развития на интернет не е трудно да се каже, че всичко, което е свързано по един или друг начин, ще бъде движещата сила на бъдещето.

Поради усъвършенстваната реклама, която голяма част от технологиите получават, е лесно да ги отхвърлите с мисли като че IoT е само за интелигентни електрически крушки, а носимите устройства са само за фитнес тракери и часовници. Но светът около вас постепенно се прекроява по начини, които трудно можете да си представите. Не е научна фантастика.

Интернет на нещата и носими устройства са две от най-бързо развиващите се технологии и най-горещите изследователски теми, които значително ще разширят приложенията на потребителската електроника (особено комуникациите).

Този път бъдещето не закъснява. Вече е тук.

Живеем в свързан свят, в който милиарди компютри, таблети, смартфони, носими устройства, игрови конзоли и дори медицински устройства, всъщност цели сгради обработват цифрово и доставят информация.

Ето един интересен малък факт за вас: изчислено е, че броят на устройствата и елементите, свързани с IoT, вече засенчва броя на хората на земята.

Обратно към бъдещето на SEO

Ще спрем до тук. Но много повече предстои.

Планирам да разбия това, което сега познаваме като оптимизация за търсачки, в серия от месечни статии, обхващащи основните аспекти. Въпреки това, терминът „SEO“ нямаше да влезе в лексикона известно време, тъй като домашната индустрия на „правене на неща, за да бъдат намерени в порталите на търсачките“ започна да се появява в средата до края на 90-те години.

Дотогава – бъдете здрави, бъдете продуктивни и поглъщайте всичко около вас в тези вълнуващи технологични времена. Ще се върна отново с още след няколко седмици.

Мненията, изразени в тази статия, са на гост-автора, а не непременно на страната на търсачките. Авторите на персонала са изброени тук.